Tools

工欲善其事,必先利其器

推荐项目

- 学习 mlir 的项目

mlir-tutorial 使用 bazel 构建项目,相比 cmake 构建个人感觉更适合新手。

- 可以抄代码的项目

IREE 架构、风格上很有 Google 的风范。

ByteIR ,字节开源项目。

跳转工具clangd

vscode 专属。

1.首先我们需要生成 compile_commands.json,以编译 llvm 为例:

- 如果是cmake编译

1

2

3

4

5

6

7

8

9

10

11

12

13

# mac上编译mlir

mkdir build && cd build

cmake -G Ninja ../llvm \

-DLLVM_ENABLE_PROJECTS=mlir \

-DLLVM_TARGETS_TO_BUILD="host" \

-DCMAKE_EXPORT_COMPILE_COMMANDS=ON \

-DCMAKE_BUILD_TYPE=Release \

-DLLVM_ENABLE_ASSERTIONS=ON \

-DLLVM_ENABLE_RTTI=ON \

-DLLVM_BUILD_EXAMPLES=ON

cmake --build . -- ${MAKEFLAGS}

cmake --build . --target check-mlir

生成的 compile_commands.json 在 build 目录下

- 如果是bazel编译

在BUILD文件配置一下下面的内容,再bazel run 一下就可以编译出compile_commands.json 详情自学:bazel-compile-commands-extractor

(1) 修改WORKSPACE,添加

1

2

3

4

5

6

7

8

9

10

11

12

load("@bazel_tools//tools/build_defs/repo:http.bzl", "http_archive")

http_archive(

name = "hedron_compile_commands",

# 记得把下面两处 commit hash 换成 github 上最新的版本

url = "https://github.com/hedronvision/bazel-compile-commands-extractor/archive/ed994039a951b736091776d677f324b3903ef939.tar.gz",

strip_prefix = "bazel-compile-commands-extractor-ed994039a951b736091776d677f324b3903ef939",

)

load("@hedron_compile_commands//:workspace_setup.bzl", "hedron_compile_commands_setup")

hedron_compile_commands_setup()

(2) 在根目录下的 BUILD.bazel 中添加下面语句

1

2

3

4

5

6

7

8

9

10

load("@hedron_compile_commands//:refresh_compile_commands.bzl", "refresh_compile_commands")

refresh_compile_commands(

name = "refresh_compile_commands",

# 指定目标 target 及其编译选项/参数,例如 `mlir-opt` 、`config=clangd`

targets = {

"//:my_output_1": "--important_flag1 --important_flag2=true"

# "//tools:triton-opt": "--config=debug --config=clang",

},

)

(3) 运行 bazel run :refresh_compile_commands

2.然后,配置vscode的clangd插件

(1)ctrl + p 输入 clangd,先点击 下载language server;

如果 clangd 下载失败,那么手动安装:下载链接:https://github.com/clangd/clangd/releases/tag/19.1.2

scp到服务器上的挂载目录

1

scp Downloads/clangd-linux-19.1.2.zip ruantingfeng@xxx:/home/ruantingfeng/projects

在docker unzip它,然后更换 “设置->Clangd:Path” 成对应的clangd二进制 clangd -> /projects/clangd/bin/clangd。然后 reload windows

(2)然后 加 settings.json , ctrl + p 打开工作区设置json,将以下内入加入

triton 默认的位置在 python/build/cmake.linux-x86_64-cpython-3.9/

1

2

3

4

5

6

7

{

"clangd.arguments": [

"--header-insertion=never",

"--compile-commands-dir=${workspaceFolder}/build/",

"--query-driver=**",

]

}

使用compile_commands.json主要是方便索引文件,特别是td生成的 inc 文件,但也可以人为从 build/tools/mlir/include/mlir/xxx/xxx 中找到编译出的 inc。

代码格式

一般使用 clang-format 工具(或者基于此的 lint.sh)。

安装

1

apt-get install clang-format

创建.clang-format

1

2

BasedOnStyle: LLVM

ColumnLimit: 80

格式化

1

2

3

4

# 单个文件

clang-format -i path/to/your/file.cpp

# 整个目录

find path/to/your/project -name '*.cpp' -o -name '*.h' | xargs clang-format -i

Adaptor

只有operands没有results的中间态,可以从adaptor中获得很多基础信息

ConversionPattern 相比 RewriterPattern 需要多传递一个 adaptor

OpAdaptor的作用:封装了op的operands

CoversionPattern 可能需要运行多遍直到 legal,过程中可能存在非法的 ir,所以推荐从 adaptor 中去取 operand 的信息。

You are supposed to lookup operands in the adaptor during a dialect conversion. 来自。

ConversionPattern和RewritePattern

1.相同点

- 都会依赖对应的

rewrite pattern driver - pattern 写好后都会分配

benefit并使用RewritePatternSet收集,然后 apply

2.不同点

- ConversionPattern

- 延时生效,往往需要多次才能legal,所以不要获取其他op的信息,可能还处于改变过程中

- adaptor, type converter, ConversionPatternRewriter

- 常配合 applyFullConversion/applyPartialConversion 使用,用于dialect2dialect的op之间变换

- RewritePattern

- 即时生效,通常需要一遍完成,所以不能用在 dialect-to-dialect 的 conversion 中

- PatternRewriter

- 一般用于优化变换,常配合 applyPatternsAndFoldGreedily 使用

- 当 pattern 可能 failed 时,千万不能修改 ir(create / earse)

- 修改ir之前,一定要确保pattern可以成功

1

2

3

4

5

6

7

8

9

10

11

12

13

14

// OpConversionPattern

struct AbsOpToMathAbsConverter : public OpConversionPattern<mhlo::AbsOp> {

using OpConversionPattern<mhlo::AbsOp>::OpConversionPattern;

LogicalResult

matchAndRewrite(mhlo::AbsOp op, OpAdaptor adaptor,

ConversionPatternRewriter &rewriter) const override {

...

// OpRewritePattern

struct TransposeSliceLayoutPattern : public OpRewritePattern<mhlo::SliceOp> {

using OpRewritePattern<mhlo::SliceOp>::OpRewritePattern;

LogicalResult

matchAndRewrite(mhlo::SliceOp op,

OpRewritePattern &rewriter) const override {

Analysis

Analisys Manager

1

mlir/include/mlir/Pass/AnalysisManager.h

Analyses 是独立于其他设施的数据结构,可以将相关的信息 perserve 起来。

例如 Transforms/CSE.cpp 中就将一些 Analyses 信息保存给下一次分析。

1

2

3

4

5

6

7

// If there was no change to the IR, we mark all analyses as preserved.

if (!changed)

return markAllAnalysesPreserved();

// We currently don't remove region operations, so mark dominance as

// preserved.

markAnalysesPreserved<DominanceInfo, PostDominanceInfo>();

但使用 markAnalysesPreserved 在 pass 间传递信息的行为是不可取的,因为该功能只是为了减少编译时间,要在 pass 间传递信息最合理的方法是设计一套 Attribute 挂在 op上。

Dataflow Analysis

概念

以下相关概念引自 南大软件分析 课程。

基础概念:

- statement

statement 是 CFG(control flow grap) 中的基本程序块。可以把IR当成statement。

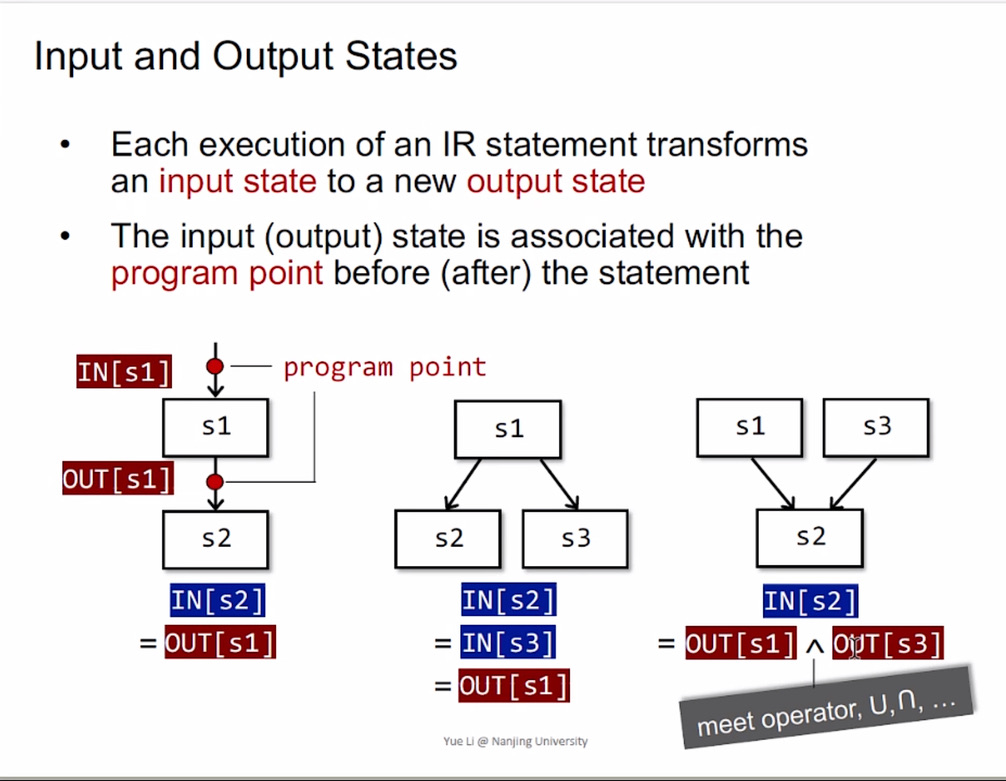

- program point

program state 是每个 statement(一般是一个ir) 前后(被观察)变量的状态。

数据流分析理论中,每个 program state 都关联了一个 program point 点,如下图,图源南大软件分析课程。

ProgramPoint 是 DataFlowAnalysis 中的基石,每次分析都是从一个 point 对象出发,visit 到更多的 point 对象。

- data flow values

静态分析完成标志:给每个program point都关联一个值(data flow values),这个值表示这个program state在那个点所有可能值的抽象

- fix point

在数据流分析中,用来描述数据数据流中信息的变化和融合的是 SemiLattice 理论。例如,在进行活跃性分析时,使用交半格可以跟踪不同数据流中变量活跃性的最小公共集合。这部分的内容可以参考南大《软件分析》课程的数据流分析。

fixedpoint 即 所有 program point 都关联一个值(data flow values),这个值表示 program state 在那个点所有可能值的抽象。

SemiLattice 是用来做两个 program point 的 data flow values 的 交汇(meet)操作(对于集合来说,就是并集/交集)。

所谓 fixedpoint iteration 算法其实是利用了 SemiLattice 的特性,保证迭代过程中一定存在一个上界(并集)/下界(交集),即 fixpoint。

- 设计一个 data flow analysis

三要素:Data Flow Values,Transfer Function和Control-flow Handing

(1) Data Flow Values: 定义 Lattice 中需要包含哪些 value,除了集合,也可能是一个值

(2) Transfer Function:定义如何前进,前向分析一般就是 out[s] = func(in[s])

(3) Control-flow Handing: 定义 Lattice 交汇时的行为,并集还是交集需要具体问题具体分析

也有某些地方称为五要素 “方向(D)、值(V)、转换函数(F)、初始值(I)和交运算(Λ)”,其中方向一般有 forward 和 backward。不同方向下转换一般不同。

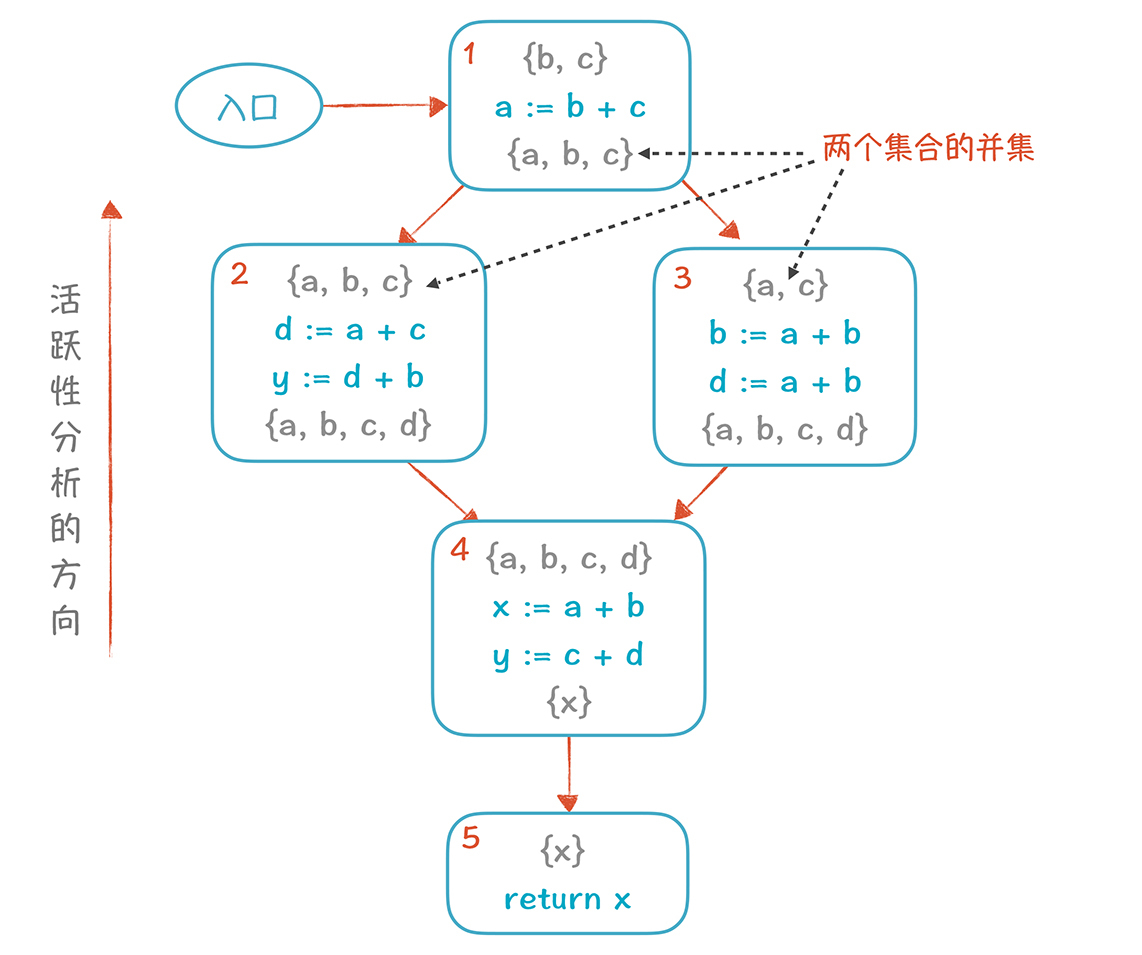

流程举例

引用编译原理之美28博客中的相关内容补充说明一下相关概念。

下图是对一个CFG的 liveness 分析结果,每个块当作是一个 program point,每个 point 前后(前: 输入变量,后: 输出变量)是可以观察到的所有元素集合(data flow values)。

当分支相遇的时,需要取两个分支的并集。即图中块4的入口 program point 的 value 等于 块2、块3出口 program point 的 value 的并集。

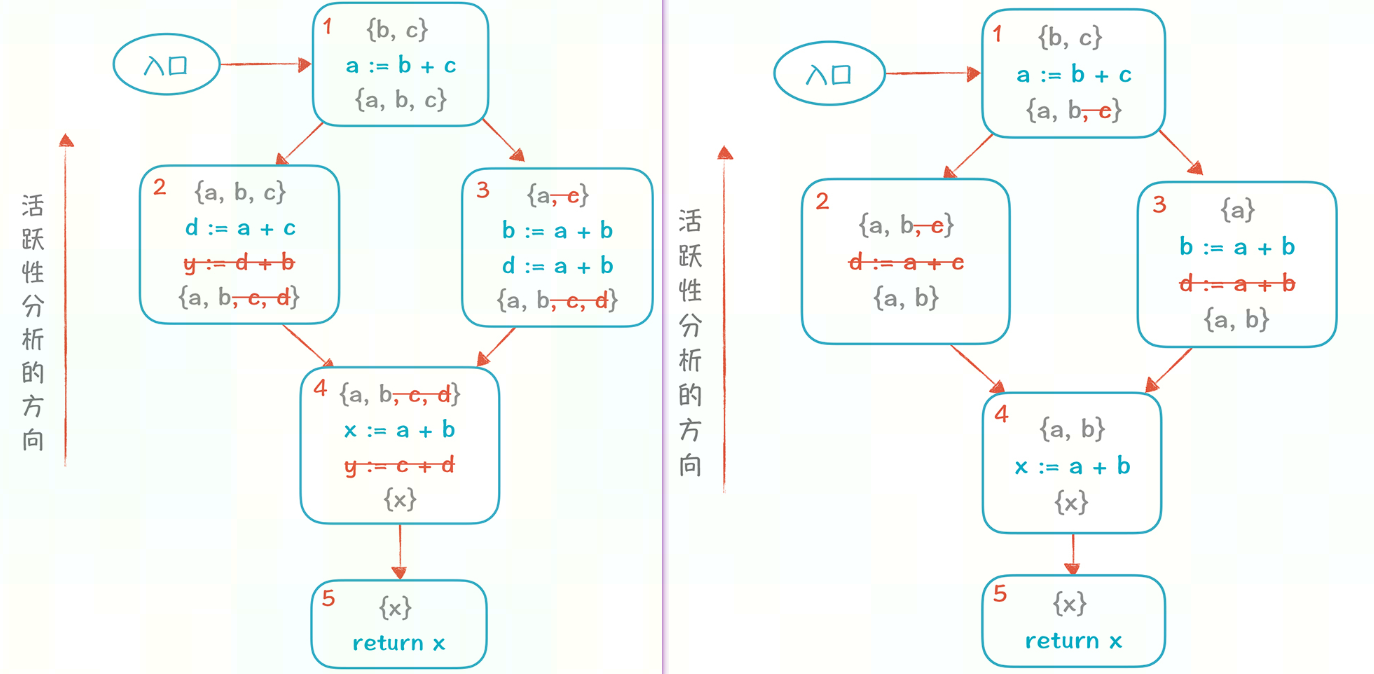

当然基于上述图,所有 data flow values 中可以删除掉和变量 y 以及相关内容

依次删除掉不活跃变量(y 和 d)后,CFG可简化为下图

这就针对当前的 CFG 完成了 DCE(Dead Code Eliminate)。

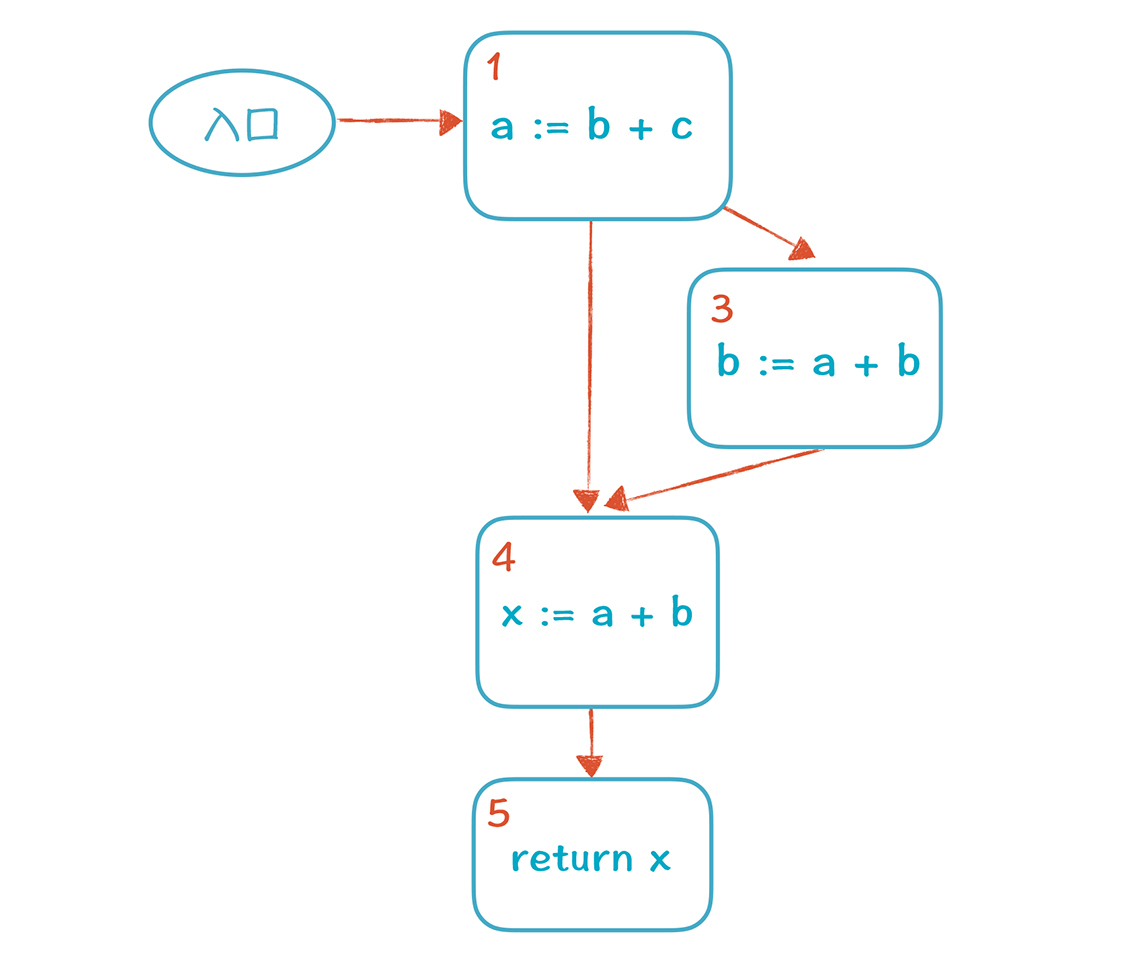

但如果 CFG 中存在回路,例如 for 循环操作(在 MLIR 中常常表现为 RegionBranchOpInterface) 时,相关 program point 中 value 将会增加很多(对所有节点进行多次计算,直到所有value中内容稳定为止)。

Dataflow Framework

1

2

3

4

include/mlir/Analysis/DataFlowFramework.h

include/mlir/Analysis/DataFlow/

lib/Analysis/DataFlowFramework.cpp

lib/Analysis/DataFlow/

1.ChangeResult

1

2

3

4

enum class [[nodiscard]] ChangeResult {

NoChange,

Change,

};

lattice 有 join(const ValueT &rhs) 方法,会合并rhs包含的信息,返回当前lattice是否更改

[[nodiscard]]来标记函数的返回值不应该被忽略。也就是说,当调用一个被标记为[[nodiscard]]的函数时, 如果返回值没有被使用,编译器会发出警告。

2.ProgramPoint

MLIR 中的 ProgramPoint 是一个 PointerUnion,可以是 Operation *, Value, Block *

3.AnalysisState

所有程序状态的基类,附加到程序点并随着分析迭代而演变的数据流信息,例如经典的 AbstractSparseLattice。

1

2

3

4

5

6

7

8

9

10

class AnalysisState {

public:

AnalysisState(ProgramPoint point) : point(point) {}

...

protected:

virtual void onUpdate(DataFlowSolver *solver) const {}

...

ProgramPoint point;

friend class DataFlowSolver;

};

4.DataFlowSolver

实现 child data-flow analyses,使用的是 fixedpoint iteration 算法。一直维护 AnalysisState 和 ProgramPoint 信息。

多种 Analysis 是同时运行的,但结果会互相影响

数据流分析的流程:

(1) 加载并初始化 children analyses

例如

1

2

3

4

5

6

7

8

std::unique_ptr<mlir::DataFlowSolver> createDataFlowSolver() {

auto solver = std::make_unique<mlir::DataFlowSolver>();

solver->load<mlir::dataflow::DeadCodeAnalysis>();

solver->load<mlir::dataflow::SparseConstantPropagation>();

solver->load<mlir::dataflow::IntegerRangeAnalysis>();

...

return solver;

}

(2) 配置并运行分析,直到达到设置的 fixpoint

solver根据IR来调用子分析(children analysis),直到达到 fixpoint

1

2

3

4

if (failed(solver->initializeAndRun(root))) {

LLVM_DEBUG(llvm::dbgs() << " - XXX analysis failed.\n");

return failure();

}

initializeAndRun 的代码:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

// mlir/lib/Analysis/DataFlowFramework.cpp

LogicalResult DataFlowSolver::initializeAndRun(Operation *top) {

// 加载所有当前context下的 analysis,进行初始化

for (DataFlowAnalysis &analysis : llvm::make_pointee_range(childAnalyses)) {

DATAFLOW_DEBUG(llvm::dbgs()

<< "Priming analysis: " << analysis.debugName << "\n");

if (failed(analysis.initialize(top)))

return failure();

}

// 执行 fixpoint 迭代:一直运行,直到 fixpoint

do {

while (!worklist.empty()) {

auto [point, analysis] = worklist.front();

worklist.pop();

DATAFLOW_DEBUG(llvm::dbgs() << "Invoking '" << analysis->debugName

<< "' on: " << point << "\n");

// 在 visit 过程还会不断地遇到新的符合条件的 point,需要加入 worklist,一直遍历下去,直到到达 fixpoint

if (failed(analysis->visit(point)))

return failure();

}

// Iterate until all states are in some initialized state and the worklist

// is exhausted.

} while (!worklist.empty());

return success();

}

理论上一定会到达 fixpoint,每个 analysis 都获得一个稳定的 Lattice。当 ProgramPoint 的 AnalysisState 发生变化时,这个信息会被添加到 worklist,这样不断迭代。

如果该过程的时间过慢,说明相关的 analysis 处理 ProgramPoint 的行为存在问题。

(3) 从 solver 中 query analysis state results

1

2

3

4

5

6

7

8

9

// 当不存在时, lookupState 会返回 null

auto analysisState = solver->lookupState<xxLattice>(Value/Op)

// 当不存在时, getOrCreateState 会创建一个未初始化的 state

auto analysisState = solver->getOrCreateState<xxLattice>(Value/Op)

auto *maybeInferredRange =

solver.lookupState<IntegerValueRangeLattice>(val);

if (!maybeInferredRange || maybeInferredRange->getValue().isUninitialized())

return failure();

(4) 其他:重要的数据成员

using WorkItem = std::pair<ProgramPoint, DataFlowAnalysis *>, std::queueworklist solver的工作队列 - SmallVector<std::unique_ptr

> childAnalyses - DenseMap<std::pair<ProgramPoint, TypeID>, std::unique_ptr

> analysisStates,表示每个 `std::pair<ProgramPoint, TypeID>`对应一个分析状态(AnalysisState)

Liveness

1

2

mlir/include/mlir/Analysis/Liveness.h

mlir/bin/Analysis/Liveness.cpp

对 op -> Liveness(Operation *op)

对 block -> liveness.getLiveness(block) -> LivenessBlockInfo

LocalAliasAnalysis

1

2

mlir/include/mlir/Analysis/AliasAnalysis/LocalAliasAnalysis.h

mlir/lib/Analysis/AliasAnalysis/LocalAliasAnalysis.h

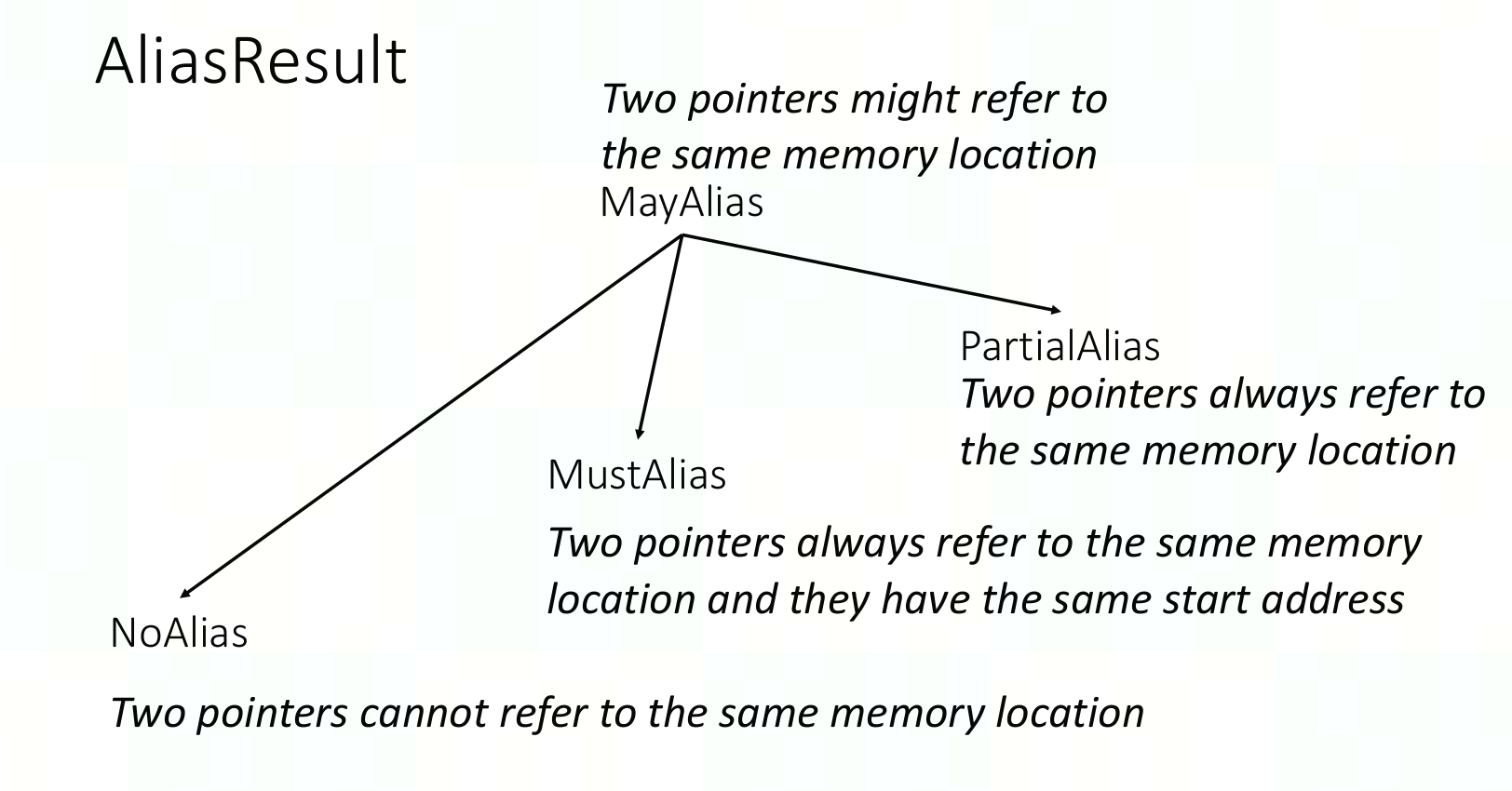

1.AliasResult: 两个location之间是否有关系

- Kind

- NoAlias

- MayAlias

- PartialAlias : 两个loc互相alias,但是部分重叠

- MustAlias

- isNO / isMay / isPartial / isMust -> bool

2.AliasResult alias(Value lhs, Value rhs);

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

// 确定一个op是否对一个value有读/写行为

bool isOpReadOrWriteInplace(Operation *op, Value val) {

auto memInterface = llvm::dyn_cast<MemoryEffectOpInterface>(op);

if (!memInterface)

return false;

llvm::SmallVector<MemoryEffects::EffectInstance> effects;

memInterface.getEffects(effects);

bool readOnVal = false;

bool writeOnVal = false;

LocalAliasAnalysis analysis;

for (MemoryEffects::EffectInstance effect : effects) {

if (llvm::isa<MemoryEffects::Read>(effect.getEffect()) &&

!analysis.alias(val, effect.getValue()).isNo()) {

readOnVal = true;

}

if (llvm::isa<MemoryEffects::Read>(effect.getEffect() &&

!analysis.alias(val, effetc.getValue()).isNo()) {

writeOnVal = true;

}

}

return readOnVal || writeOnVal;

}

3.collectUnderlyingAddressValues

重载了多种形式,常用的有以下输入:

(Value, SmallVectorImpl

&output) - (OpResult result, unsigned maxDepth, DenseSet

&visited, SmallVectorImpl &output) - result.getOwner() -> ViewLikeOpInterface -> 继续调用 viewOp.getViewSource()

- result.getOwner() -> RegionBranchOpInterface

- (BlockArguement arg, unsigned maxDepth, DenseSet

&visited, SmallVectorImpl &output)

SliceAnalysis

用来遍历 use-def 链的 analysis 一般可以将 use-def 理解为

- def : 写

- use : 读

1

2

3

4

5

6

7

____

\ / defs (in some topological order)

\/

op

/\

/ \ uses (in some topological order)

/____\

1.getSlice

(1)getForwardSlice : 获得root op的use链 (向ir的结尾找)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

从 0 开始追,可以获得 {9, 7, 8, 5, 1, 2, 6, 3, 4}

0

___________|___________

1 2 3 4

|_______| |______|

| | |

| 5 6

|___|_____________|

| |

7 8

|_______________|

|

9

输入, root可以是op,也可以是value

1

2

3

4

5

void getForwardSlice(Operation *op, SetVector<Operation *> *forwardSlice,

const ForwardSliceOptions &options = {});

void getForwardSlice(Value root, SetVector<Operation *> *forwardSlice,

const ForwardSliceOptions &options = {});

(2)getBackWardSlice : 获得root op的def链 (向ir的开头找)

1

2

3

4

5

6

7

8

9

10

11

12

从 node 8 开始, 可以获得 {1, 2, 5, 3, 4, 6}

1 2 3 4

|_______| |______|

| | |

| 5 6

|___|_____________|

| |

7 8

|_______________|

|

9

输入, root可以是op,也可以是value。

如果是op,那么会追踪组成该op的其所有operand;如果是value,那么会追踪该value的产生链,使用value就可以从BlockArguement开始追。

1

2

3

4

5

void getBackwardSlice(Operation *op, SetVector<Operation *> *bac

const BackwardSliceOptions &options = {});

void getBackwardSlice(Value root, SetVector<Operation *> *backwa

const BackwardSliceOptions &options = {});

2.SliceOptions

TransitiveFilter filter : 设置遍历条件,当遍历到的节点不符合 filter 时停止(注意第一个遍历对象就是 rootOp)

bool inclusive : 返回的 sliceSetVec中 是否包含 root(op / value)

ForwardSliceOptions : using ForwardSliceOptions = SliceOptions;

BackwardSliceOptions : 相比 SliceOptions 多一个参数 ` bool omitBlockArguments`,这个参数控制是否避免遍历 blockArguement

1

2

3

4

5

6

7

8

9

10

11

12

13

14

BackwardSliceOptions sliceOptions;

// 不遍历 blockArg(可以理解为到blockArg这就结束)

sliceOptions.omitBlockArguments = true;

// 所有加入backwardSlice的op都需要满足以下条件

// 第一下会遍历本身

sliceOptions.filter = [rootOp](Operation *slice) -> bool {

return !llvm::isa<arith::ConstantOp, tensor::EmptyOp, memref::AllocOp,

scf::ForallOp, scf::ForOp, scf::IfOp>(slice)

&& rootOp->isProperAncestor(slice);

};

SetVector<Operation *> backwardSlice;

getBackwardSlice(targetOp, &backwardSlice, sliceOptions);

Attribute

1

mlir/include/mlir/IR/Attribute.h

常见类型:

- StringAttr

- UnitAttr / IntegerAttr / IndexAttr

- BoolAttr

- ArrayAttr

- DictionaryAttr

- DenseElementsAttr

1

2

auto value = constantOp.getValue().dyn_cast<DenseElementsAttr>();

if (value && value.isSplat()) // 一个 DenseElementsAttr 如果是 splat 的,那么所有值都相同

常用方法:

1.使用 OpBuilder 可以创建这类 Attr,例如

rewriter.getI64IntegerAttr 或builder.getI64IntegerAttr。

2.src: AttrTy

- get() 例如从SmallVector

变成ArrayAttr

1

2

SmallVector<Attribute, 8> mappings;

ArrayAttr tmp = ArrayAttr::get(context, mappings)

getName()

setValue()

getValue() 对于IntegertAttr会返回APInt,之后一般可以接

getSExtValue(),来将APInt转为int64_tsrc : operation*

getAttr / getAttrOfType ,一般get完之后要dyn_cast(可能cast失败,所以要判空)到对应的AttrType,例如

1 2 3 4 5 6 7 8

op->getAttr(getAliasAttrKey()).dyn_cast_or_null<mlir::IntegerAttr>() op->getAttrOfType<DenseI64ArrayAttr> constexpr llvm::StringLiteral getXXXAttrKey() { return llvm::StringLiteral("sadkjasd"); } auto attr = op->getAttrOfType<BoolAttr>(getXXXAttrKey()); if (attr) return attr.getValue();

hasAttr / hasAttrOfType

- setAttr(StringRef name, Attribute value)

- name可以

constexpr llvm::StringLiteral形式定义在头文件中 - funcOp→setAttr(attrName, IntegerAttr::get(intType, 1));

- 例如

1 2 3

// 为 `arith::FastMathInterface op` 设置 `fastmathAtrr` op->setAttr(op.getFastMathAttrName(), mlir::arith::FastMathFlagsAttr::get( op->getContext(), arith::FastMathFlags::fast));

- name可以

removeAttr

- func::FuncOp::setResultAttr

operation、attribute、type关系

| 专用指针 | 通用指针 | 值 |

|---|---|---|

| AddOp | Operation * | Operation |

| IntegerType | Type | TypeStorage |

| IntegerAttr | Attribute | AttributeStorage |

Block

1

mlir/include/mlir/IR/Block.h

Block 包含 BlockArgument(使用getArguements()获得)和 BlockOperand

BlockArgument

继承自 Value。

Block *getOwner() 返回该arg属于哪个block。

unsigned getArgNumber() 返回该arg的index。

BlockOperand

继承自IROperand。

unsigned getOperandNumber() 返回该operand的index。

使用

1.返回 Block

Operation *->getBlock()Value->getParentBlock()

2.遍历block

walk

1

block->walk([&](Operation *op) {...

只遍历同层op

1

Operation &workOp : rootBlock->getOperations()

Builder

1

2

mlir/include/mlir/IR/Builders.h

mlir/lib/IR/Builders.cpp

Builder 用于创建新的 MLIR 操作,例如各种 Type, Attr, Affine Expressions 等

OpBuilder

OpBuilder 继承自 Builder 类,额外提供了struct Listener和class InsertPoint

ImplicitLocOpBuilder继承自 OpBuilder,并不需要 Location 信息。

InsertPoint

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

Listener *getListener() const { return listener; }

void clearInsertionPoint();

InsertPoint saveInsertionPoint();

// insertionPoint设在block内的iterator处

void setInsertionPoint(Block *block, Block::iterator insertPoint);

// insertionPoint设到op前面,本质上还是找到op在block内的iterator

void setInsertionPoint(Operation *op) {

setInsertPointPoint(op->getBlock(), Block::iterator(op));

}

// insertionPoint设到op后面

void setInsertionPointAfter(Operation *op) {

setInsertPointPoint(op->getBlock(), ++Block::iterator(op));

}

// insertionPoint设到value后面

void setInsertionPointAfterValue(Value val) {

if (Opeartion *op = val.getDefiningOp()) {

setInsertionPointAfter(op);

} else {

auto blockArg = llvm::cast<BlockArguement>(val);

setInsertionPointToStart(blockArg.getOwner());

}

}

// insertionPoint设到block开头

void setInsertionPointToStart(Block *block);

// insertionPoint设到block结尾

void setInsertionPointToEnd(Block *block);

create

1

2

3

4

5

6

Block *createBlock(Region *parent, Region::iterator insertPt = {},

TypeRange argTypes = std::nullopt,

ArrayRef<Location> locs = std::nullopt);

// createBlock(®ion, /*insertPt=*/{}, argTypes, argLocs);

Operation *insert(Operation *op);

Operation *create(const OperationState &state);

- OpTy create(loc, Args &&..args);

先创建 OperationState 对象,再调用 OpTy::build 方法创建 Operation 对象

- createOrFold

返回值是 Value (也可以直接作为 OpFoldResult 使用,会有一个隐式转换)

创建op后立即尝试fold,一般在创建某些有xxxOp.cpp中有opFoldPattern的op时使用,例如一些arith dialect 中的op 以及 memref.dim

参见: mlir/lib/Dialect/Complex/IR/ComplexOps.cpp

clone

1

2

3

4

5

6

7

8

Operation *clone(Operation &op, IRMapping &mapper);

Operation *clone(Operation &op);

Operation *cloneWithoutRegions(Operation &op, IRMapping &mapper) {

return insert(op.cloneWithoutRegions(mapper));

}

Operation *cloneWithoutRegions(Operation &op) {

return insert(op.cloneWithoutRegions());

}

例:使用linalg.reduce的region创建一个linalg.map

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

// op 是 linalg.reduce

Value emptyOp = rewriter.create<tensor::EmptyOp>(

loc, initDims, dstType.getElementType());

auto mapOp = rewriter.create<linalg::MapOp>(

loc, ValueRange(op.getDpsInputs()), emptyOp,

[&](OpBuilder &b, Location loc, ValueRange args) {});

// 下面的代码等价于 rewriter.inlineRegionBefore(op->getRegion(0), mapOp->getRegion(0), mapOp->getRegion(0)->begin());

Block *opBody = op.getBody();

llvm::SmallVector<Value> bbArgs;

for(Operation *opOperand : op.getOpOperandsMatchingBBargs()) {

bbArgs.emplace_back(opBody->getArgument(

opOperand->getOperandNumber()));

}

Block *mapOpBody = mapOp.getBlock();

SmallVector<BlockArgument> mapOpBbargs;

for (OpOperand *opOperand : mapOp.getOpOperandsMatchingBBargs()) {

mapOpBbargs.emplace_back(mapOpBody->getArgument(opOperand->getOperandNumber());

}

assert(mapOpBbargs.size() == bbArgs.size());

IRMapping bvm;

for (auto [bbarg, newBBarg] : llvm::zip(bbArgs, mapOpBbargs)) {

bvm.map(bbarg, newBBarg); // 这个操作其实就是在 DenseMap<Value, Value> 中建立映射关系。

}

rewriter.setInsertionPointToStart(mapOpBody);

for (Operation &operation : *reduceOpBody) {

rewriter.clone(operation, bvm);

}

Listener

Listener用于hook到OpBuilder的操作,Listener继承自 ListenerBase,ListenerBase有两种 kind

1

2

3

4

5

6

7

8

// Listener() : ListenerBase(ListenerBase::Kind::OpBuilderListener)

struct ListenerBase {

enum class Kind {

OpBuilderListener = 0,

RewriterBaseListener = 1

};

...

}

Listener常用两个函数为 notifyOperationInserted(Operation *Op) 和 notifyBlockCreated(Block *block)。自定义rewriter时,一般需要 override 这两个函数。

RewriterBase

1

2

mlir/include/mlir/IR/PatternMatch.h

mlir/lib/IR/PatternMatch.cpp

继承自 OpBuilder,且将 Listener 设置为 RewriterBaseListener

1

2

3

4

5

6

class RewriterBase : public OpBuilder {

public:

struct Listener : public OpBuilder::Listener {

Listener() : OpBuilder::Listener(Kind::RewriterBaseListener) {}

};

}

常用函数:

1.notify : 在正式对op修改前都需要调用notify,以便listener监听

notifyOperationModified : in-place 修改

notifyOperationReplaced : 调用 replaceOp时触发

1 2 3 4 5

if (auto *listener = dyn_cast_if_present<RewriteBase::Listener>(rewriter.getListener())) { listener->notifyOperationReplaced(op, existing); } rewriter.replaceAllUsesWith(op->getResults()) opsToErase.push_back(op);

notifyOperationErased : 调用 earseOp时触发

2.modifyOpInPlace : 会调用 startOpModification 和 finalizeOpModification

1

2

3

4

5

6

7

8

9

10

11

12

13

struct PrintOpLowering : public OpConversionPattern<toy::PrintOp> {

using OpConversionPattern<toy::PrintOp>::OpConversionPattern;

LogicalResult

matchAndRewrite(toy::PrintOp op, OpAdaptor adaptor,

ConversionPatternRewriter &rewriter) const final {

// We don't lower "toy.print" in this pass, but we need to update its

// operands.

rewriter.modifyOpInPlace(op,

[&] { op->setOperands(adaptor.getOperands()); });

return success();

}

};

3.replaceAllUsesWith

ForwardingListener

可以将所有 notify 发送给另外一个 OpBuilder::Listener,用于创建监听链条

1

2

struct ForwardingListener : public RewriterBase::Listener {

ForwardingListener(OpBuilder::Listener *listener) : listener(listener) {}

IRRewriter

继承自 RewriteBase,当 PatternRewriter 不可用时才使用

1

2

3

4

5

6

class IRRewriter : public RewriterBase {

public:

explicit IRRewriter(MLIRContext *ctx, OpBuilder::Listener *listener = nullptr)

: RewriterBase(ctx, listener) {}

explicit IRRewriter(const OpBuilder &builder) : RewriterBase(builder) {}

};

PatternMatch

PatternBenefit

一般配合 Pattern 使用,表示一个pattern的benefit,benefit越高越先apply

1

patterns.add<DoWhileLowering>(patterns.getContext(), /*benefit=*/2);

benefit的取值范围为 0到65535

Pattern

1

2

3

4

5

6

7

8

9

10

class Pattern {

/// This enum represents the kind of value used to select the root operations

/// that match this pattern.

enum class RootKind {

Any,

OperationName,

InterfaceID,

TraitID

};

...

有match、rewrite、matchAndRewrite这些函数,也会设置 PatternBenefit (默认为1)

RewritePattern

继承自pattern

1

2

3

4

5

6

7

8

virtual LogicalResult matchAndRewrite(Operation *op,

PatternRewriter &rewriter) const {

if (succeeded(match(op))) {

rewrite(op, rewriter);

return success();

}

return failure();

}

一些子类:

1.OpOrInterfaceRewritePatternBase

OpRewritePattern : 使用 SourceOp::getOperationName() 来match

OpInterfaceRewritePattern : 使用 SourceOp::getInterfaceID() 来match

1

2

3

4

5

6

7

8

9

struct AddOpPat : public OpRewritePattern<AddOp> {

using OpRewritePattern<AddOp>::OpRewritePattern;

LogicalResult matchAndRewrite(AddOp op,

PatternRewriter & rewriter) const override{

static EraseDeadLinalgOp : public OpInterfaceRewritePattern<LinalgOp> {

using OpInterfaceRewritePattern<LinalgOp>::OpInterfaceRewritePattern;

LogicalResult matchAndRewrite(LinalgOp op,

PatternRewriter &rewriter) const override{

2.OpTraitRewritePattern

使用 TypeID::get

() 来match 例如某些elementwiseTrait :

OpTraitRewritePattern<OpTrait::Elementwise>

RewritePatternSet

1

2

3

4

5

RewritePatternSet(MLIRContext *context,

std::unique_ptr<RewritePattern> pattern)

: context(context) {

nativePatterns.emplace_back(std::move(pattern));

}

1.新建pattern

所以一般新建 RewritePatternSet 对象时都得传入 context

1

RewritePatternSet patterns(&getContext());

然后再一些函数来归类pattern

1

2

3

4

populateAffineToStdConversionPatterns(patterns);

void mlir::populateAffineToStdConversionPatterns(RewritePatternSet &patterns) {

...

}

也可以通过PDLL来写pattern(包含constrict和rewrite)

1

2

RewritePatternSet(PDLPatternModule &&pattern)

: context(pattern.getContext()), pdlPatterns(std::move(pattern)) {}

2.add : 向set中添加pattern

1

2

add(LogicalResult (*implFn)(OpType, PatternRewriter &rewriter),

PatternBenefit benefit = 1, ArrayRef<StringRef> generatedNames = {})

3.clear : 清空set中的pattern

PatternRewriter

继承自 RewriteBase, 用于重写(transform)现有 MLIR 操作的工具。它提供了一组方法,允许用户在遍历操作并修改它们时进行规则匹配和替换。在rewrite pattern中才使用

PatternRewriter &rewriterConversionPatternRewriter &rewriter: 相比pattern rewriter要多传入一个adaptor,详细见 Conversion 节

常用操作

1.设置插入点(与builder同)

- setInsertionPoint(Operantion *)

- setInsertionPointAfter

2.block

getBlock()

3.创建

- create

(…) create(OperationState)

1 2 3 4 5 6 7 8

OperationState state(op->getLoc(), op->getName().getStringRef(), {newInput, newKernel, newInit}, {resTy}, op->getAttrs(), op->getSuccessors()); for (Region &r : op->getRegions()) { Region *newRegion = state.addRegion(); b.cloneRegionBefore(r, *newRegion, newRegion->begin()); } Operation *newOp = b.create(state);

4.替换

replaceOp(Operation *op, Operation *newOp)

replaceOp(Operation *op, ValueRange newValues())

例如getResults()作为ValueRange输入

replaceAllOpUsesWith(Operation *from, ValueRange to) / replaceAllOpUsesWith(Opeation *from, Operation *to )

replaceUsesWithIf(Value from, Value to, func_ref) / replaceUsesWithIf(ValueRange from, Value to, func_ref) / replaceUsesWithIf(Operation *op, Value to, func_ref)

1 2 3 4 5 6

// 替换forallOp外的使用 rewriter.replaceUsesWithIf(workOp->getResult(0), forallOp->getResults(idx), [&](OpOperand use) {return !forallOp->isProperAncestor(use.getOwner()) // 仅替换当前op的使用 rewriter.replaceUsesWithIf(emptyOp->getResult(), newEmptyOp->getResult(), [&](OpOperand use) { return use.getOwner() == op; });

replaceAllUsesExcept(Value from, Value to, Operation *exceptedUser) 本质是使用

replaceUsesWithIf来实现1 2

rewriter.replaceUsesWithIf(from, to, [&](OpOperand use) { return use.getOwner() != exceptedUser; });

5.消除

earseOp(Operation *op) : 如果要在pattern中删除op,最好使用

rewriter.earseOp,使用op自带的erase函数代码运行时会在debug模式出问题earseBlock(Block *block)

示例

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

struct AddOpPat : public OpRewritePattern<AddOp> {

using OpRewritePattern<AddOp>::OpRewritePattern;

LogicalResult matchAndRewrite(AddOp op,

PatternRewriter & rewriter) const override{

xxx

return success();

}

};

class AddOpPatPass : public impl::AddOpPatPassBase<AddOpPatPass> {

explicit AddOpPatPass() = default;

void runOnOperation() override {

RewriterPatternset patterns(&getContext());

patterns.add<AddOpPat>(patterns.getContext());

if (failed(applyPatternAndFlodGreedily(getoperation(), std::move(patterns))))

return signalPassFailure();

};

}

std::unique_ptr<pass> mlir::createAddOpPatPass() {

return std::make_unique<AddOpPatPass>;

}

Bufferize

bufferization dialect

bufferization:将逻辑计算语义的tensor转为物理内存语义的buffer

- bufferize::AllocTensorOp

申请一块空间,使用给定shape创建一个bufferize allocation。常会传入一个可选的 srcOp,表示从这个srcOp拷贝出的数据,此时就传入的 ValueRange dynamicShape就应为空。

该op主要是帮助bufferization过程提供一个 handler,并且这样产生的alloc_tensor op没有不会产生 read-after-write 冲突,也不会alias其他buffer,可以再进行 in-place bufferize

- bufferization.to_tensor

将memref转为转为tensor语义下的操作

- bufferization.materialize_in_destination

相当于在tensor层面的copy

one-shot-bufferize

(copy from大佬)

1

mlir/lib/Dialect/Bufferization/IR/BufferizableOpInterface.cpp

1.OneShotBufferize pass

对于每个有 BufferizableOpInterface 的op都进行bufferize

- 声明:mlir/include/mlir/Dialect/Bufferization/Transforms/Passes.td

- 先基于tensor的SSA use-def链进行原位分析来确认哪些operand可以in-place bufferize.(尽量减少alloc和copy, 提高性能)

- destination-passing style op(继承

DestinationStyleOpInterface): 某一个operand和dst的buffer可复用,所以分配了该operand的buffer后,无需再分配dst的buffer:eg: %t0 = tensor.insert %f into %dest[%idx], buffer(%t0)和buffer(%dest)是完全一致的; - 非destination-passing style op:对每个OpOperand产生一个新的buffer allocation, eg:tensor.generate

- 所有新allocate的buffer后续都会deallocate,不然会内存泄露

- destination-passing style op(继承

- TensorCopyInsertion:对确定是out-of-place的operands插入 copies,insertTensorCopies()函数。

- 调用bufferize接口bufferize()函数来实现bufferize. bufferizeOp()函数。

- 函数签名的layout map由

function-boundary-type-conversion选项单独控制,可选的参数有3种:infer-layout-map,fully-dynamic-layout-mapandidentity-layout-map, 默认是infer-layout-map。无法精确推测时,函数参数类型为fully dynamic layout maps。 bufferize-function-boundaries是一个用来对funcOp、returnOp、callOp进行bufferize的flag- funcArg一般可以bufferize,除非有

bufferization.writable = false

- 先基于tensor的SSA use-def链进行原位分析来确认哪些operand可以in-place bufferize.(尽量减少alloc和copy, 提高性能)

- 实现:mlir/lib/Dialect/Bufferization/Transforms/Bufferize.cpp

- struct OneShotBufferizePass {void runOnOperation() override }

- Configure type converter, 先获得 unknownTypeConversionOption:

- 若是LayoutMapOption::IdentityLayoutMap, bufferization::getMemRefTypeWithStaticIdentityLayout(tensorType, memorySpace);

- 否则,只能是LayoutMapOption::FullyDynamicLayoutMap,bufferization::getMemRefTypeWithFullyDynamicLayout(tensorType,memorySpace);

- Configure op filter. 依据编译选项设置不可bufferize的op

- 依据编译选项是否激活bufferizeFunctionBoundaries确定调用哪个函数进行bufferize:

- 若激活了,runOneShotModuleBufferize(moduleOp, opt, &statistics)

- 反之,runOneShotBufferize(moduleOp, opt, &statistics)

- createCanonicalizerPass()

- createCSEPass()

- createLoopInvariantCodeMotionPass()

- Configure type converter, 先获得 unknownTypeConversionOption:

- struct OneShotBufferizePass {void runOnOperation() override }

- 示例:mlir/test/Dialect/Bufferization/Transforms/one-shot-module-bufferize-out-params.mlir, mlir/test/Dialect/Bufferization/Transforms/one-shot-module-bufferize.mlir

2.transform IR : transform.bufferization.one_shot_bufferize 有很多可选的参数

- layout{IdentityLayoutMap} { bufferize_function_boundaries = true }

- {bufferize_function_boundaries = true }

- 定义:mlir/include/mlir/Dialect/Bufferization/TransformOps/BufferizationTransformOps.td

- 实现:transform.bufferization.one_shot_bufferize的代码:

- mlir/lib/Dialect/Bufferization/TransformOps/BufferizationTransformOps.cpp: transform::OneShotBufferizeOp::apply()函数,从transform IR提供的各个参数中获得OneShotBufferizationOptions options,之后主要调用

- runOneShotModuleBufferize()

- insertTensorCopies(moduleOp, options)

- bufferizeOp() 会调用

BufferizableOpInterface::bufferize()函数来对每个op进行具体的bufferize

- runOneShotBufferize()

- insertTensorCopies(target, options)

- bufferizeOp() 会调用

BufferizableOpInterface::bufferize()函数来对每个op进行具体的bufferize

- runOneShotModuleBufferize()

- mlir/lib/Dialect/Bufferization/TransformOps/BufferizationTransformOps.cpp: transform::OneShotBufferizeOp::apply()函数,从transform IR提供的各个参数中获得OneShotBufferizationOptions options,之后主要调用

- 示例:mlir/test/Dialect/Bufferization/Transforms/transform-ops.mlir

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

// 编译命令:mlir-opt --test-transform-dialect-interpreter

func.func @matmul(%A: tensor<12x9xf32>, %B: tensor<9x6xf32>, %C: tensor<12x6xf32>) -> tensor<12x6xf32> {

%D = linalg.matmul ins(%A, %B: tensor<12x9xf32>, tensor<9x6xf32>) outs(%C: tensor<12x6xf32>) -> tensor<12x6xf32>

return %D : tensor<12x6xf32>

}

// use identity layout at function boundaries.

transform.sequence failures(propagate) {

^bb0(%arg1: !pdl.operation):

transform.bufferization.one_shot_bufferize layout{IdentityLayoutMap} %arg1 {bufferize_function_boundaries = true }

}

// result is 连续的memref

func.func @matmul(%arg0: memref<12x9xf32>, %arg1: memref<9x6xf32>, %arg2: memref<12x6xf32>) -> memref<12x6xf32> {

linalg.matmul ins(%arg0, %arg1 : memref<12x9xf32>, memref<9x6xf32>) outs(%arg2 : memref<12x6xf32>)

return %arg2 : memref<12x6xf32>

}

// use default at function boundaries.

transform.sequence failures(propagate) {

^bb0(%arg1: !pdl.operation):

transform.bufferization.one_shot_bufferize %arg1 {bufferize_function_boundaries = true }

}

// result is 非连续的memref(所有func.func的args和返回值均是非连续的)

func.func @matmul(%arg0: memref<12x9xf32, strided<[?, ?], offset: ?>>, %arg1: memref<9x6xf32, strided<[?, ?], offset: ?>>, %arg2: memref<12x6xf32, strided<[?, ?], offset: ?>>) -> memref<12x6xf32, strided<[?, ?], offset: ?>> {

linalg.matmul ins(%arg0, %arg1 : memref<12x9xf32, strided<[?, ?], offset: ?>>, memref<9x6xf32, strided<[?, ?], offset: ?>>) outs(%arg2 : memref<12x6xf32, strided<[?, ?], offset: ?>>)

return %arg2 : memref<12x6xf32, strided<[?, ?], offset: ?>>

}

Canonicalize

Canonicalize 的形式是进行 IR 的等价变换,目的是让 compiler 更方便分析(使 DAG 中的节点和连接减少),而不是为了性能考虑。 例如某些情况下 x + x 可能比 x * 2 性能更好,但 x * 2 在 DAG 中表现的 Deps 关系更加清晰简单。

有需要的 op 自己注册,需要在 td 中加上 let hasCanonicalizer = 1;, 然后在对应的 cpp 中添加相关方法,例如:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

namespace {

struct FoldAdjacentBitcast : public OpRewritePattern<BitcastOp> {

using OpRewritePattern<BitcastOp>::OpRewritePattern;

LogicalResult matchAndRewrite(BitcastOp op,

PatternRewriter &rewriter) const override {

if (auto parentOp = op.getSrc().getDefiningOp<BitcastOp>()) {

// The adjacent bitcast must have only use.

if (parentOp->hasOneUse()) {

auto src = parentOp.getSrc();

RankedTensorType dstTy = op.getDest().getType();

auto newBitcast =

rewriter.createOrFold<BitcastOp>(op.getLoc(), dstTy, src);

rewriter.replaceOp(op, newBitcast);

return success();

}

}

return failure();

}

};

} // namespace

void BitcastOp::getCanonicalizationPatterns(RewritePatternSet &results,

MLIRContext *context) {

results.add<FoldAdjacentBitcast>(context);

}

在 Canonicalizer pass 执行时,会贪心(greedy apply,一般是达到最大iter次数)地调用所有 loaded dialects 中 op 的 CanonicalizationPatterns

此外,类似的还有 fold 方法,同样需要在 td 中添加 let hasFolder = 1;

1

2

3

4

5

6

OpFoldResult BitcastOp::fold(FoldAdaptor) {

if (getSrc().getType() == getDest().getType()) {

return getSrc();

}

return {};

}

fold 和 canonicalize 的区别:

- fold 方法一般只跟 op 本身相关,且是一定会带来收益

- canonicalize 方法一般需要分析 op 连接关系,且主要目标是简化后序分析,而非带来收益

- PassManager 在运行时会先尝试调用 op 的 fold 方法,而 canonicalize 方法需要显式调用 canonicalize

CRTP

CRTP (Curiously Recurring Template Pattern,奇异递归模版模式),在 MLIR 的类型定义中十分常见。

1

2

class DialectFoldInterface

: public DialectInterface::Base<DialectFoldInterface>

表现形式为:将派生类(DialectFoldInterface)传给基类(DialectInterface)

作用:为基类提供一些派生类信息,再通过基类中实现方法继承来扩展派生类本身。 这种方法区别于虚函数继承,可以避免运行时虚函数表为了动态分派而进行查找的开销,实现静态多态(零运行时开销)

推荐一个博客:C++ CRTP 简介

其他 CPP in MLIR 相关内容见:https://tfruan2000.github.io/posts/cpp-in-mlir/

Conversion

形式:将写好的pattens加入RewriterPatternSet并设置benefit,再apply

1

2

3

4

5

6

void runOnOperation() override {

RewritePatternSet patterns(&getContext());

patterns.add<xxxx>(patterns.getContext(), /*benefit*/2)

if (failed(applyPatternsAndFoldGreedily(getOperation(), std::move(patterns))));

return signalPassFailure();

}

常见的apply形式:

applyPartialConversion:如果结果是合法(以ConversionTarget参数来判断)则保留。如果有未转换的illegal操作,并不会转换失败,将混合存在。applyFullConversion:调用pattern对目标进行转换,直至IR满足ConversionTarget设置的目标合法,pattern必须成功才会产生合法的target。要求所有illegal都被转换applyPatternsAndFoldGreedily:尽可能地多次修改,pattern可以失败

前两种常用于dialect conversion,需要多传入一个ConversionTarget参数,greedilyConversion一般用于优化pass

ConversionTarget

常用定义op

1

2

3

4

5

6

7

MLIRContext &ctx = getContext();

ConversionTarget target(ctx);

target.addIllegalDialect<SparseTensorDialect>();

target.addLegalDialect

target.addDynamicallyLegalDialect

target.addLegalOp

target.addDynamicallyLegalOp

例如只对标量op进行转换的pattern

1

2

3

4

5

6

7

8

9

10

11

12

13

target.markUnknownOpDynamicallyLegal([](Operation *op) {

if (isa<math::MathDialect>(op->getDialect()) &&

llvm::isa<math::LogOp, math::ExpOp,...>(op)) {

return op->getResultTypes().front().isa<ShapedType>();

}

return true;

});

RewritePatternSet patterns(&ctx);

patterns.add<xxx>(patterns.getContext());

if(failed(applyParticalCpnversion(getOperation(), target,

std::move(patterns))))

return signalPassFailure();

ConversionPattern相比RewriterPattern一般多一个adaptor参数,用于访问op的opernads

1

2

3

4

5

6

7

8

9

10

11

12

13

// 常用于op的dialect2dialect下降

struct AbsOpToMathAbsConverter : public OpConversionPattern<mhlo::AbsOp> {

using OpConversionPattern<mhlo::AbsOp>::OpConversionPattern;

LogicalResult

matchAndRewrite(mhlo::AbsOp op, OpAdaptor adaptor,

ConversionPatternRewriter &rewriter) const final {

// 常用于op的优化行为,也可以用于dialect2dialect中的op下降

struct TransposeSliceLayoutPattern : public OpRewritePattern<mhlo::SliceOp> {

using OpRewritePattern<mhlo::SliceOp>::OpRewritePattern;

LogicalResult

matchAndRewrite(mhlo::SliceOp op,

PatternRewriter &rewriter) const override {

dialect conversion

1

mlir/lib/Transforms/Utils/DialectConversion.cpp

即dialect_a中的op对应转换到dialect_b中,例如vector dialect → gpu dialect

dialect conversion一般包含op conversion和type conversion

op conversion

1

mlir/include/mlir/IR/PatternMatch.h

1.OpRewritePattern

以vector2gpu为例

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

// mlir/lib/Conversion/ArithToSPIRV/ArithToSPIRV.cpp

// namespace内定义许多op conversion patterns

namespace{

// final 跟在类后面,说明该类不能再被继承

// const 修饰 matchAndRewrite 方法,说明该方法不能改变类的成员变量。

struct ConstantCompositeOpPattern final

: public OpConversionPattern<arith::ConstantOp> {

using OpConversionPattern::OperationConversionPattern;

LogicalResult matchAndRewrite(arith::ConstantOp op,

opAdaptor adaptor,

ConversionPatternRewriter &rewriter) const override {

...

}

}

...

void mlir::populateArithToSPIRVPatterns(RewritePatternSet &patterns) {

patterns.add<ConstantCompositeOpPattern>(patterns.getContext());

// 可以设置pattern的/*benefit=*/

// patterns.add<ConstantCompositeOpPattern>(patterns.getContext(), /*benefit=*/2);

...

}

} // namespace

当 OpRewritePattern match 的是 template 时

1

2

3

4

5

6

7

8

9

10

11

12

13

14

template<class OpTy> // 有些函数要调用时要用 template

struct XXXPattern : public OpRewritePattern<OpTy> {

using OpRewritePattern<OpTy>::OpRewritePattern;

LogicalResult matchAndRewrite(OpTy op,

PatternRewriter &rewriter) const override {

// 判断是否是想处理的op

// 1. 用isa: 此时 isa 中不能放多种,只能一个一个判断

if (!llvm::isa<xxx>(Op1) || !llvm::isa<xxx>(Op2))

return failure();

// 2. 用 std::is_same_v

if (!std::is_same_v(OpTy, Op1))

return failure();

}

};

2.OpInterfaceRewritePattern

专门匹配某种 OpInterface 的pattern。例如

1

2

3

4

5

6

7

8

9

struct ViewLikeOpXXXPattern

: public OpInterfaceRewritePattern<ViewLikeOpInterface> {

ViewLikeOpXXXPattern(MLIRContext *ctx)

: OpInterfaceRewritePattern<ViewLikeOpInterface>(ctx) {}

LogicalResult mathAndRewrite(ViewLikeOpInterface viewOp,

PatternRewriter &rewriter) const override {

...

}

}

type conversion

1

mlir/Conversion/LLVMCommon/TypeConverter.h

对type对改写一般通过 typeConverter ,常配合 ConversionTarget 使用。其一般包含三个主要函数

addConversion:定义通用的类型转换规则,当调用convertType方法时,会依次检查addConversion中注册的规则。- 当调用

getTypeConverter()->convertType(inputType)时启用

- 当调用

addTargetMaterialization:sourceType→targetType- 例如,op2 以 op1 作为 operand,当 op1 和 op2 的 resType 被转换后, op2 期望其 operandType 和 op1 给出的并不符合,所以就需要将中间类型值转换为目标类型值。

addSourceMaterialization:targetType→sourceTypeaddArgumentMaterialization

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

static Value materializeToXXXCallback(OpBuilder &builder, Type type, ValueRange values) {

if (xxx)

...

return nullptr;

}

class MyTypeConvert : public TypeConverter {

public:

MyTypeConvert() {

addConversion([](Type type)) -> Type {

if (isSomeType(type))

return ...;

return type;

});

addTargetMaterialization([](OpBuilder &builder, Type type, ValueRange values) {

if (...)

return builder.create<SomeOp>(type, values);

return nullptr;

});

addSourceMaterialization(materializeToXXXCallback);

addArgumentMaterialization(materializeToXXXCallback);

// 可以默认使用 unrealized_conversion_cast,如下

auto addUnrealizedCast = [](OpBuilder &builder, Type type, ValueRange inputs,

Location loc) {

auto cast = builder.create<UnrealizedConversionCastOp>(loc, type, inputs);

return std::optional<Value>(cast.getResult(0));

}

addSourceMaterialization(addUnrealizedCast);

addTargetMaterialization(addUnrealizedCast);

addArgumentMaterialization(addUnrealizedCast);

}

};

Dataflow

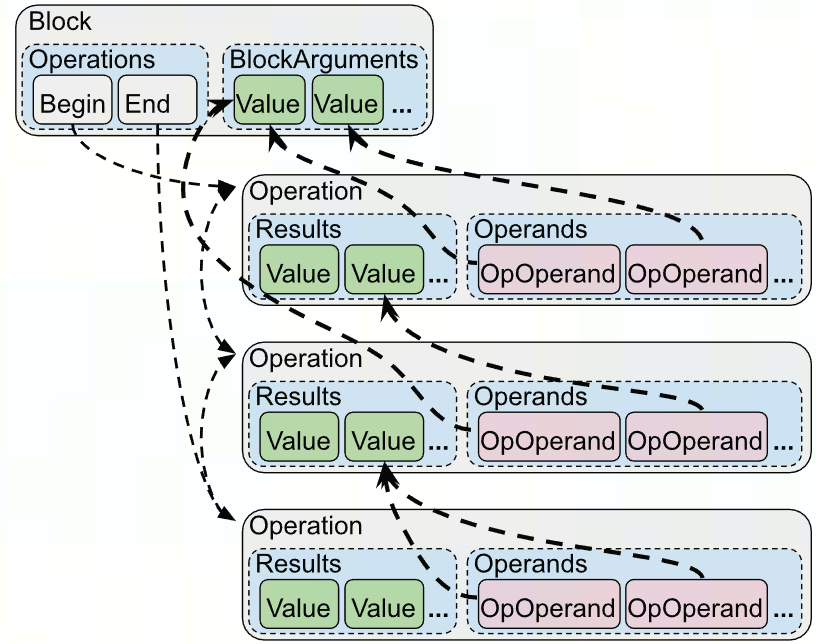

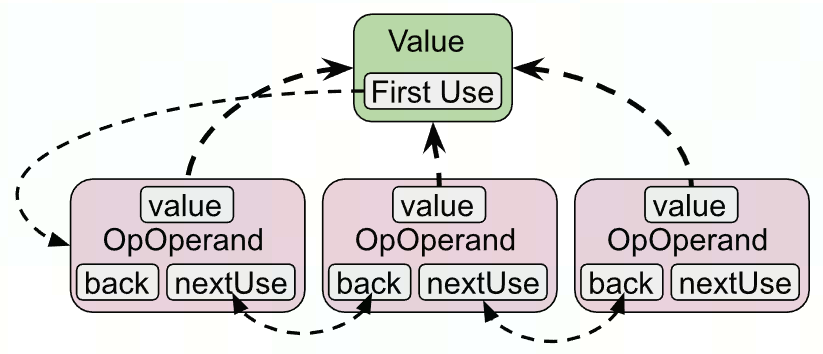

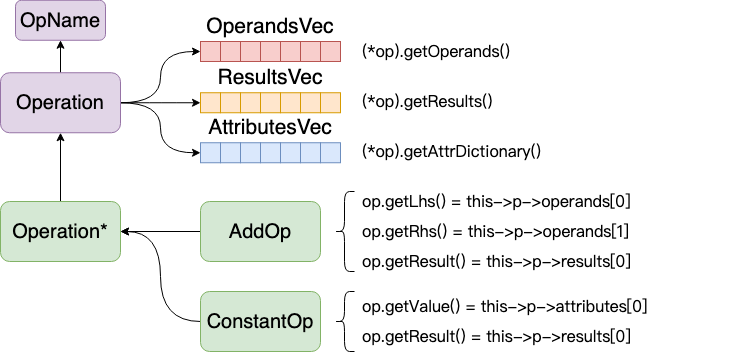

MLIR中的数据流图是由Operation和Value构成的:(use-def chain)

- Value的值要么来自于Operation的result,要么来自于BlockArgument

- 调用getDefiningOp时,BlockArgument会返回null

- 每个Operation的Operand都是到Value的指针

Operation都包含Results和Operands;Results中包含多个OpResult实例,Operands中包含多个OpOperand实例

- 修改Operand时,实际是修改OpOperand,对应value的use-chain也会被修改

Operation找Value

- getOperands() / getResults()

1

2

3

4

5

6

for (auto operand : op.getOperands()) {

if (auto *def = op.getDefiningOp()) {

} else {

// BlockArgument

}

}

- getOpOperands() 用于需要修改operand时

1

2

3

4

5

6

7

IRMapping mapping;

mapping().map(op1.getResults(), op2.getResults());

for (auto &opOperand : op3.getOpOperands()) {

// 将 op3 的参数里含有 op1 results 的替换为 op2 的 mapping

// mapping.lookupOrDefault(a): 如果mapping中存在就用结果,反之用 a

opOperand.set(mapping.lookupOrDefault(opOperand.get()));

}

value找op

getDefiningOp:可能返回null

- getUses :返回OpOperand迭代器,即使用了这个value的OpOperand集合

- OpOperand &operand : value.getUses()

- getUsers :返回Operation迭代器,即直接依赖于该value的operation集合

- user_iterator相当于对use_iterator使用getOwner()

- use.getOwner() → Operation*

dataflow framework

见 Analysis 节

DataType

1

mlir/include/mlir/IR/BuiltinTypes.h

从ShapedType使用getElementType()获得

类型:

- FloatType

- getF32

- getWidth

- IndexType :target word-size integer(一般是64位)

- IntegerType

- Signless: 单纯表示64位的数据,是否当作有无符号,完全根据前后ir运算

- Signed

- UnSigned

用法

- 判断类型

- isInteger

- isInteger(unsigned width)

- isIndex

- isIntOrIndex

- isIntOrFloat

- isInteger

- 生成 get

- RankedTensorType::get(ArrafRef

shapes, elemType) 例如 RankedTenorType newType = RankedTensorType::get({srcDims[0], 1}), srcType.getElementType) - IntegerType::get(op→getContext(), 64);

- RankedTensorType::get(ArrafRef

Debug

1

2

3

4

#include "llvm/include/llvm/Support/Debug.h"

LLVM_DEBUG(llvm::dbgs() << "Original loop:\n"

<< *region->getParentOp() << "\n");

LLVM_DEBUG(llvm::dbgs() << "Checking op: " << *op << "\n");

Dianostic

1

2

3

mlir/docs/Diagnostics.md

mlir/include/mlir/IR/Diagnostics.h

mlir/lib/IR/Diagnostics.cpp

当rewrite-pattern使用op的verify(rewrite出的op是否合法)来判断pattern是否match-and-rewrite成功时,那apply-pattern时的报错就是不必要的,可以通过去除handler的办法消除掉这些不必要的报错

使用

1

2

3

4

5

6

7

8

9

auto *context = &getContext();

auto handlerID =

context->getDiagEngine().registerHandler([](Diagnostic &) { return; });

...

RewritePatternSet patterns(context);

patterns.add<xxx>(patterns.getContext());

(void)applyPatternsAndFoldGreedily(getOperation(), std::move(patterns));

...

context->getDiagEngine().eraseHandler(handlerID);

Dialect

新增一个dialect可以参考最近mlir中新增的polynomial dialect ,然后就是补充各种dialect2dialect的conversion了

组成

详见 MLIR Survey 一文 的第二节 dialect 和 operation 相关的介绍

DialectRegistry

The DialectRegistry maps a dialect namespace to a constructor for the matching dialect :为dialect中的op外挂新的属性

1

mlir/include/mlir/IR/DialectRegistry.h

例如为linalg的op挂上新的interface

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

void mlir::xxx::utils::registerLinalgAggregatedOpInterfaceModel(

DialectRegistry ®istry) {

registry.addExtension(+[](MLIRContext *ctx, LinalgDialect *dialect) {

linalg::MapOp::attachInterface<MapOpInterface>(*ctx);

MatmulOp::attachInterface<

MatmulOpInterface<MatmulOp, linalg::Conv2DNhwcFhwcOp>>(*ctx);

BatchMatmulOp::attachInterface<

MatmulOpInterface<BatchMatmulOp, linalg_ext::BatchConv2DNhwcFhwcOp>>(

*ctx);

ReduceOp::attachInterface<ReduceOpInterface>(*ctx);

});

}

// 定义上例如,其中AggregatedOpInterface需要在LinalgExtInterface.td定义

template <typename SrcOpTy, typename DstOpTy>

struct MatmulOpInterface : public AggregatedOpInterface::ExternalModel<

MatmulOpInterface<SrcOpTy, DstOpTy>, SrcOpTy> {

FailureOr<SmallVector<Operation *>>

decomposeOperation(Operation *op, Operation *value,

PatternRewriter &rewriter) const {

}

};

Affine

op

op定义详见 affine dialect ops

- affine.apply

- affine.max / affine.min

- affine.index

- affine.for

- affine.if

op相关的一些函数

1

mlir/lib/Dialect/Affine/IR/AffineOps.cpp

AffineMap

1

2

3

mlir/inlcude/mlir/IR/AffineMap.h

mlir/lib/IR/AffineMap.cpp

mlir/Dialect/Affine/IR/AffineOps.h

getFilteredIdentityMap创建条件过滤affinemap

1

2

3

/// getFilteredIdentityMap(3, [false, false, true]) -> affine_map<(d0, d1, d2) -> (d2)>

AffineMap getFilteredIdentityMap(MLIRContext *ctx, unsigned numDims,

llvm::function_ref<bool(AffineDimExpr)> keepDimFilter);

getPermutationMap创建一个permutation的affinemap

1

2

3

/// ArrrayRef<int64_t>

static AffineMap getPermutationMap(ArrayRef<unsigned> permutation,

MLIRContext *context);

getMultiDimMapWithTargets创建一个指定输出行为的affinemap,没有计算,只是排序。输入的numDims>=targets.size()

1

2

3

/// * getMultiDimMapWithTargets(3, [2, 1])

/// -> affine_map<(d0, d1, d2) -> (d2, d1)>

static AffineMap getMultiDimMapWithTargets(unsigned numDims, ArrayRef<unsigned> targets, MLIRContext *context);

bool isEmpty() : Returns true if this affine map is an empty map, i.e., () -> ().

bool isSingleConstant() : Returns true if this affine map is a single result constant function.

int64_t getSingleConstantResult()

bool isConstant() : Returns true if this affine map has only constant results.

SmallVector

getConstantResults() : Returns the constant results of this map. This method asserts that the map has all constant results. - unsigned getNumDims() : AffineMap的numDims属性

- unsigned getNumSymbols()

- unsigned getNumResults()

unsigned getNumInputs()

- **ArrayRef

getResults()** 返回每个result的计算affineExpr AffineExpr getResult(unsigned idx)

- getDimPosition : 返回result的pos,要求这个idx对应的result是一个 AffineDimExpr。

AffineDimExpr 意味着这个result不是计算出来的,一般是等于某个输入。

例如affine_map<(d0, d1) -> (d1, d0)>,这个 AffineMap有两个输出,对其getDimPosition(0) = 1, getDimPosition(1) = 0。这个函数一般用在 permutation 的 AffineMap 上。

1

2

3

unsigned AffineMap::getDimPosition(unsigned idx) const {

return cast<AffineDimExpr>(getResult(idx)).getPosition();

}

- getResultPosition : 返回输入input是当前AffineMap的第几个输出

1

2

3

4

5

6

7

8

9

std::optional<unsigned> AffineMap::getResultPosition(AffineExpr input) const {

if (!isa<AffineDimExpr>(input))

return std::nullopt;

for (unsigned i = 0, numResults = getNumResults(); i < numResults; i++) {

if (getResult(i) == input)

return i;

}

return std::nullopt;

}

- isFunctionOfDim

1

2

3

4

5

6

/// Return true if any affine expression involves AffineDimExpr `position`.

bool isFunctionOfDim(unsigned position) const {

return llvm::any_of(getResults(), [&](AffineExpr e) {

return e.isFunctionOfDim(position);

});

}

- 创建 affine.max / affine.min

makeComposedFoldedAffineMin, makeComposedFoldedAffineMax

例如下面的代码会创建一个 affine.min affine_map<(d0) -> (256, d0)>(%operand)

1

2

3

4

OpFoldResult c256 = rewriter.createOrFold<arith::ConstantIndexOp>(loc, 256);

OpFoldResult minVal = mlir::affine::makeComposedFoldedAffineMin(

rewriter, loc, AffineMap::getMultiDimIdentityMap(2, loc.getContext()),

ArrayRef({getAsOpFoldResult(operand), c256}));

MutableAffineMap

可以set一些属性,比如

void setResult(unsigned idx, AffineExpr result) { results[idx] = result; }simplify()

使用 analysis 简化affinemap,大体是折叠常量相关的计算

AffineExpr

1

2

mlir/include/mlir/IR/AffineExpr.h

mlir/lib/IR/AffineExpr.cpp

- AffineExprKind getKind() : 返回kind

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

Add,

/// RHS of mul is always a constant or a symbolic expression.

Mul,

/// RHS of mod is always a constant or a symbolic expression with a positive

/// value.

Mod,

/// RHS of floordiv is always a constant or a symbolic expression.

FloorDiv,

/// RHS of ceildiv is always a constant or a symbolic expression.

CeilDiv,

/// This is a marker for the last affine binary op. The range of binary

/// op's is expected to be this element and earlier.

LAST_AFFINE_BINARY_OP = CeilDiv,

/// Constant integer.

Constant,

/// Dimensional identifier.

DimId,

/// Symbolic identifier.

SymbolId,

- AffineBinaryOpExpr 继承自 AffineExpr

- AffineExpr getLHS()

- AffineExpr getRHS()

- AffineDimExpr

- unsigned getPosition()

- AffineConstantExpr

- int64_t getValue()

例: affine_map (d1, d2) -> (d1 - d2) 这是一个 AffineBinaryOpExpr,kind是add,表达为(1 * d1, -1 * d2)。lhs和rhs都是 AffineConstantExpr,value分别是(1, -1)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

/// Return "true" if `candidate` is a negated expression, i.e., Mul(-1, expr).

/// If so, also return the non-negated expression via `expr`.

static bool isNegatedAffineExpr(AffineExpr candidate, AffineExpr &expr) {

auto mulExpr = dyn_cast<AffineBinaryOpExpr>(candidate);

if (!mulExpr || mulExpr.getKind() != AffineExprKind::Mul)

return false;

if (auto lhs = dyn_cast<AffineConstantExpr>(mulExpr.getLHS())) {

if (lhs.getValue() == -1) {

expr = mulExpr.getRHS();

return true;

}

}

if (auto rhs = dyn_cast<AffineConstantExpr>(mulExpr.getRHS())) {

if (rhs.getValue() == -1) {

expr = mulExpr.getLHS();

return true;

}

}

return false;

}

Linalg

Linalg is designed to solve the High-level Hierarchical Optimization

Linalg IR 比较常见的 transfroms:

- Progressive Buffer Allocation

- Parametric Tiling

- Tiled Producer-Consumer Fusion with Parametric Tile-And-Fuse

- Map to Parallel and Reduction Loops and Hardware

Linalg Dialect 是很重要的一个层级,在这之前的 dialect 更多得是对计算的描述,表达原有的 ML 程序。而从 Linalg 开始,就会经过一系列变换(tile, fuse, promotion, bufferize)贴近目标硬件。

op

- linalg.generic:其实是以完美嵌套循环表示的计算

- linalg.fill

- linalg.map{ arith.op / math.op }

1

2

3

4

5

6

7

8

9

10

11

12

13

auto mapOp = rewriter.create<linalg::MapOp>(

loc, adaptor.getOperands().front(), emptyTensor,

[&](OpBuilder &b, Location loc, ValueRange args) {

Type elementType = getElementTypeOrSelf(emptyTensor);

Value operand = args.front();

Value innerResult =

elementType.isa<FloatType>()

? rewriter.create<math::AbsFOp>(loc, elementType, operand)

.getResult()

: rewriter.create<math::AbsIOp>(loc, elementType, operand)

.getResult();

b.create<linalg::YieldOp>(loc, innerResult);

});

- linalg.matmul

- linalg.batch_matmul

function

- LinalgInterface

- bool hasDynamicShape()

SmallVector

getIndexingMapsArray() 1 2 3 4 5 6 7 8 9

// 判断linalgOp是ElementwiseOp auto isElementwiseLinalg = [](linalg::LinalgOp linalgOp) -> bool { if (linalgOp.getNumDpsInints() != 1) return false; return llvm::all_of(linalgOp.getIndexingMapsArray(), [](AffineMap map) { return map.isIdentity(); }) && hasOnlyScalarElementwiseOp(linalgOp->getRegion(0)); };

LinalgInterface

1

2

mlir/lib/Dialect/Linalg/IR/LinalgInterfaces.cpp

mlir/include/mlir/Dialect/Linalg/IR/LinalgInterfaces.td

- getNumLoops() -> unsigned

即返回 getIteratorTypesArray().size()

- getNumParallelLoops

返回 loops 中 parallel轴的数量,这些轴一般可以并行(用scf.forall来tile),而reduction轴都只能用scf.for来tile

- getIndexingMapsArray

返回region内的计算。generic op内部是由一堆的计算组成的,即可以看成一个AffineMap。

- getRegionOutputArgs

返回region内的outArg,配合 SliceAnalysis 的 matchReduction 可以收集 reductions op

1

2

3

4

5

SmallVector<Operation *, 4> combinerOps;

if (!matchReduction(op.getRegionOutputArgs(), 0, combinerOps) ||

combinerOps.size() != 1)

return failure();

Operation *payloadOp = combinerOps[0];

例如 linalg.reduce {addf} 将会返回 arith.addf

- payloadUsesValueFromOperand

输入是 OpOperand,返回这个 OpOperand 是否被使用,由此来获得准确 Memory-Effect。(inputOperand有user则有read,initOperand必被write,若有user则有read)

例如 https://github.com/llvm/llvm-project/pull/92079/files 中

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

static void getGenericEffectsImpl(

SmallVectorImpl<SideEffects::EffectInstance<MemoryEffects::Effect>>

&effects,

LinalgOp linalgOp) {

SmallVector<Value> inputOperands = linalgOp.getDpsInputs();

for (auto [index, operand] : llvm::enumerate(inputOperands)) {

if (!llvm::isa<MemRefType>(operand.getType()))

continue;

if (linalgOp.payloadUsesValueFromOperand(&linalgOp->getOpOperand(index))) {

effects.emplace_back(MemoryEffects::Read::get(), operand, /*stage=*/0,

/*effectOnFullRegion=*/true,

SideEffects::DefaultResource::get());

}

}

unsigned inputOperandSize = inputOperands.size();

for (auto [index, operand] : llvm::enumerate(linalgOp.getDpsInits())) {

if (!llvm::isa<MemRefType>(operand.getType()))

continue;

if (linalgOp.payloadUsesValueFromOperand(

&linalgOp->getOpOperand(index + inputOperandSize))) {

effects.emplace_back(MemoryEffects::Read::get(), operand, /*stage=*/0,

/*effectOnFullRegion=*/true,

SideEffects::DefaultResource::get());

}

effects.emplace_back(MemoryEffects::Write::get(), operand, /*stage=*/0,

/*effectOnFullRegion=*/true,

SideEffects::DefaultResource::get());

}

}

conversion

强烈推荐项目 triton-linalg,大佬们的力作

SCF

1

mlir/lib/Dialect/SCF/IR/SCF.cpp

op

scf.for : 循环body必须串行执行,因为每次迭代返回值会写回blockarg,所以下一次使用 blockarg的值受上次迭代的影响

1 2 3 4 5 6 7

%alloc = memref.alloc() : memref<16xi32> %1 = scf.for %arg0 = %c0_i32 to %c8_i32 step %c1_i32 iter_args(%arg1 = %alloc) -> (memref<16xi32>) { %allco_new = memref.alloc() : memref<16xi32> use %arg1 ... scf.yield %alloc_new : memref<16xi32> }scf.forall / scf.parallel :循环body的程序是可以的并发执行,没有前后依赖的 可以使用多线程的方式来执行,线程的id就是循环的迭代变量 从scf到launch这种转换是可以通过代码自动完成的,需要的额外信息就是每一个循环的轴到launch的轴的映射关系

1 2 3 4

scf.forall (%thread_id_1, %thread_id_2) in (%num_threads_1, %num_thread_2) { // ... } }创建一个新的 forall

1 2 3 4 5

auto newforallOp = rewriter.create<scf::ForallOp>( loc, forallOp.getMixedLowerBound(), forallOp.getMixedUpperBound(), forallOp.getMixedStep(), forallOp.getOutputs(), forallOp.getMapping()); rewriter.eraseBlock(newforallOp.getBody()); newforallOp.getRegion().takeBody(forallOp.getRegion());

scf.if

1

2

3

4

5

6

Block *IfOp::thenBlock() { return &getThenRegion().back(); }

YieldOp IfOp::thenYield() { return cast<YieldOp>(&thenBlock()->back()); }

auto cond = op.getCondition();

auto thenYieldArgs = op.thenYield().getOperands();

auto elseYieldArgs = op.elseYield().getOperands();

有一个 scf.if 的canonicalize pattern,叫 ConvertTrivialIfToSelect,可以尽量消除 else region

经常在 bufferize 后的 canonicalize 起效,因为bufferize 后 scf.yield 的operand更关系更明确了

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

// ./build/bin/mlir-opt test_if.mlir --split-input-file --one-shot-bufferize --canonicalize

// 不能命中,因为thenRegion的yield value属于thenRegion

// %1 = arith.cmpi slt, %arg1, %c0_i32 : i32

// %2 = scf.if %1 -> (memref<2xi32>) {

// %alloc_0 = memref.alloc() {alignment = 64 : i64} : memref<2xi32>

// linalg.map { math.absi } ins(%0 : memref<2xi32, strided<[?], offset: ?>>) outs(%alloc_0 : memref<2xi32>)

// scf.yield %alloc_0 : memref<2xi32>

// } else {

// scf.yield %alloc : memref<2xi32>

// }

func.func @test_if (%arg0 : tensor<2xi32>, %arg1 : i32) -> tensor<2xi32> {

%cst = arith.constant 0 :i32

%0 = tensor.empty() : tensor<2xi32>

%1 = linalg.fill ins(%cst : i32) outs(%0 : tensor<2xi32>) -> tensor<2xi32>

%2 = arith.cmpi slt, %arg1, %cst : i32

%3 = scf.if %2 -> tensor<2xi32> {

%4 = tensor.empty() : tensor<2xi32>

%5 = linalg.map{math.absi} ins(%arg0 : tensor<2xi32>) outs(%4: tensor<2xi32>)

scf.yield %5 : tensor<2xi32>

} else {

scf.yield %1 : tensor<2xi32>

}

return %3 : tensor<2xi32>

}

// -----

// 可以命中,但不产生select,因为trueVal == falseVal

// %1 = arith.cmpi slt, %arg1, %c0_i32 : i32

// scf.if %1 {

// linalg.map { math.absi } ins(%0 : memref<2xi32, strided<[?], offset: ?>>) outs(%alloc : memref<2xi32>)

func.func @test_if (%arg0 : tensor<2xi32>, %arg1 : i32) -> tensor<2xi32> {

%cst = arith.constant 0 :i32

%0 = tensor.empty() : tensor<2xi32>

%1 = linalg.fill ins(%cst : i32) outs(%0 : tensor<2xi32>) -> tensor<2xi32>

%2 = arith.cmpi slt, %arg1, %cst : i32

%3 = scf.if %2 -> tensor<2xi32> {

%5 = linalg.map{math.absi} ins(%arg0 : tensor<2xi32>) outs(%1: tensor<2xi32>)

scf.yield %5 : tensor<2xi32>

} else {

scf.yield %1 : tensor<2xi32>

}

return %3 : tensor<2xi32>

}

// -----

// 产生select

// %1 = arith.cmpi slt, %arg1, %c0_i32 : i32

// %2 = arith.select %1, %alloc, %alloc_0 : memref<2xi32>

// scf.if %1 {

// linalg.map { math.absi } ins(%0 : memref<2xi32, strided<[?], offset: ?>>) outs(%alloc : memref<2xi32>)

func.func @test_if (%arg0 : tensor<2xi32>, %arg1 : i32) -> tensor<2xi32> {

%cst = arith.constant 0 :i32

%0 = tensor.empty() : tensor<2xi32>

%1 = linalg.fill ins(%cst : i32) outs(%0 : tensor<2xi32>) -> tensor<2xi32>

%cst1 = arith.constant 1 :i32

%6 = tensor.empty() : tensor<2xi32>

%7 = linalg.fill ins(%cst1 : i32) outs(%6 : tensor<2xi32>) -> tensor<2xi32>

%2 = arith.cmpi slt, %arg1, %cst : i32

%3 = scf.if %2 -> tensor<2xi32> {

%5 = linalg.map{math.absi} ins(%arg0 : tensor<2xi32>) outs(%1: tensor<2xi32>)

scf.yield %5 : tensor<2xi32>

} else {

scf.yield %7 : tensor<2xi32>

}

return %3 : tensor<2xi32>

}

Tensor

1

mlir/Dialect/Tensor/IR/Tensor.h

op

tensor.empty

1

2

3

4

auto srcShape = srcType.getShape();

SmallVector<int64_t> sizes(srcShape.begin(), srcShape.end())

Value input = rewriter.create<tensor::EmptyOp>(loc, sizes, srcType.getElementType());

// RankedTenorType newType = RankedTensorType::get({srcDims[0], 1}), srcType.getElementType)

tensor.extract_slice [$offsets] [$sizes] [$strides]- getSource()

- getResult()

- getType() → getResult().getType()

tensor.collapse_shape

1

2

3

SmallVector<int64_t> srcDims;

RankedTensorType collapseType = RankedTensorType::get(srcDims, srcType.getElementType());

rewriter.create<tensor::CollapseShapeOp>(loc, collapseType, collapseIn, collapseIndices);

tensor.expend_shape

应用上可以使用tensor.collapse_shape和tensor.expand_shape消除operands中dimSize=1的维(往往这些维度不会影响数据的layout),创建降维后的op时候需要为某些op set额外的属性,例如linalg.transpose的permutation、linalg.reduce和linalg.broadcast的dimensions

tensor.parallel_insert_slice

创建 scf.forall 时,如果有 output,就需要使用 tensor.parallel_insert_slice 来返回

- forallOp.getTerminator() -> 返回

scf.forall_in_parallel - forallOp.getTerminator().getYieldingOps() -> 返回

scf.forall_in_parallel内的tensor.parallel_insert_slice

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

// forallOp.getTerminator() 返回的是 scf.forall.in_parallel op

rewriter.setInsertPointToTheEnd(forallOp.getTerminator().getBody());

// 如果 forall 循环只进行一次(即 ub - lb = 1),那么返回的行为就和 scf.forall 的 inductionVar 无关

auto zero = rewriter.getIndexAttr(0);

auto one = rewriter.getIndexAttr(1);

// 记返回值为 returnVal,对应 forall 的第idx个输出

Value returnVal;

int64_t idx;

auto rankTy = llvm::dyn_cast<RankedTensorType>(returnVal.getType());

assert(rankTy && "expected returnVal has a RankedTensorType");

SmallVector<OpFoldResult> sizes;

for (const auto &shape : llvm::enumerate(rankTy.getShape())) {

if (ShapedType::isDynamic(shape.value())) {

sizes.emplace_back(rewriter.createOrFold<tensor::DimOp>(

loc, collapseRes, shape.index()));

continue;

}

sizes.emplace_back(rewriter.getIndexAttr(shape.value()));

}

SmallVector<OpFoldResult> offsets(rank, zero);

SmallVector<OpFoldResult> strides(rank, one);

rewriter.create<tensor::ParallelInsertSliceOp>(

loc,

/*source=*/resVal,

/*dest=*/forallOp.getOutputBlockArguments()[idx],

/*offsets=*/offsets,

/*sizes=*/sizes,

/*strides=*/strides);

MemRef

更详细介绍见后文

tensor章节,说明了 MLIR 中 tensor 和 memref 的关系

%a = memref.view/subview %b:a相当于是b的别名,二者具有相同的baseptr,指向同一块内存,修改b/a时,也会影响a/b。

getMixedOffsets / getMixedSizes / getMixedStrides → SmallVector

memref addr的分配:MemRef的内存分配是由MLIR运行时系统负责的,它会根据MemRef的大小和数据类型在内存中分配一段连续的内存空间,并将其地址存储在MemRef的指针中。

1

getStridesAndOffset(MemRefType t, SmallVectorImpl<int64_t> &strides, int64_t &offset);

如果使用 memref.reinterpret_cast 将 memref<axbxi64, stride<[s1, s2], offset: off>> 从 i64 转为 i32,那么输出的 memref 应为

1

memref<axbx2xi32, stride<[2 * s1, 2 * s2, 1], offset: 2 * off>>

memref 在组织上可以视为一维数组,判断其连续性时需要从最内维(innermost)开始判断。 需要满足 stride[rank - 1] == 1, 并且 stride[i + 1] * shape[i + 1] = shape[i] (0 <= i < rank)。

那如果行主序的存储模式是从最低维开始判断memref的连续性,那列主序的存储模式是从最高维开始吗?

-> 并不是的,行主序和列主序是内存中数据的组织模式,并不影响 memref 表达的形式,所以列主序也是一样从最内维开始判断的。最终硬件会负责解释这个memref。如果内存中数据排布是以行为主序的,那么列主序数据存储后在硬件中会有类似 transpose 的行为将其转为硬件组织数据的模式。

memrefType

MemRefType 主要由 layout 描述: offset, size, stride, memrefspace

- getElementType() → Type

- getShape() → ArrayRef

- getLayout() → MemRefLayoutAttrInterface

1

auto strided = dyn_cast<MemRefLayoutAttrInterface>(t.getLayout());

- getMemorySpace() → Attribute

- MemRefType::get() 提供了多种构造的方法

1

2

3

4

// 如果只有 shape 和 elemTy 两个属性,但想构造一个包含 memory space 的 memref,那么可以额外使用 Builder

MemRefType resTy =

MemRefType::get(dstType.getShape(), dstType.getElementType());

resTy = MemRefType::Builder(resTy).setMemorySpace(srcTy.getMemorySpace());

offset / stride / size

获得memrefType的offset / stride / size的方法

1.自定义dialect支持OffsetOp和StrideOp

类似:[mlir][memref] Introduce memref.offset and memref.stride ops

2.getStridesAndOffset

注意:现在变成 MemRefType.getStridesAndOffset()

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

// mlir/lib/IR/BuiltinTypes.cpp

LogicalResult mlir::getStridesAndOffset(MemRefType t,

SmallVectorImpl<int64_t> &strides,

int64_t &offset) {

if (auto strided = llvm::dyn_cast<StridedLayoutAttr>(t.getLayout())) {

llvm::append_range(strides, strided.getStrides());

offset = strides.getOffset();

return success();

}

AffineExpr offsetExpr;

SmallVector<AffineExpr, 4> strideExprs;

if (failed(::getStridesAndOffset(t, strideExprs, offsetExpr)))

return failure();

if (auto cst = dyn_cast<AffineConstantExpr>(offsetExpr))

offset = cst.getValue();

else

offset = cst.getValue();

for (auto e : strideExprs) {

if (auto c = dyn_cast<AffineConsantExpr>(e))

strides.push_back(c.getValue());

else

strides.push_back(c.getValue());

}

return success();

}

3.MemRefDescriptor

1

#include "mlir/Conversion/LLVMCommon/MemRefBuilder.h"

1

2

3

4

MemRefDescriptor memrefDesc(csrc);

Value offsetval = memrefDesc.offset(builder, loc);

// stride(OpBuilder &builder, Location loc, unsigned pos);

Value strideVal = memrefDesc.stride(builder, loc, 0);

4.Range

1

2

3

4

5

struct Range {

OpFoldResult offset;

OpFoldResult size;

OpFoldResult stride;

};

Range数据结构一般使用以下方法获得

1

2

auto tileInfo = cast<TilingInterface>(op);

SmallVector<Range> domain = op.getInterationDomain(rewriter);

由于是 OpFoldResult 类型,访问时使用getValueOrCreateConstantIndexOp方法

取size的时候也经常先dyn_cast为Attribute

1

2

3

if (inAttr = range.size.dyn_cast<Attribute>()) {

tileSize =inAttr.cast<IntegerAttr>().getInt();

}

示例:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

// mlir/lib/Dialect/SCF/Transforms/TileUsingInterface.cpp

FailureOr<SmallVector<scf::ForOp>>

mlir::scf::lowerToLoopsUsingSCFForOp(RewriterBase &rewriter,

TilingInterface op) {

if (op->getNumResults() > 0) {

return rewriter.notifyMatchFailure(

op, "unable to lower to loops operations with return values");

}

SmallVector<Range> domain = op.getIterationDomain(rewriter);

SmallVector<Value> ivs;

SmallVector<scf::ForOp> loops;

Location loc = op.getLoc();

for (auto loopRange : domain) {

Value offsetVal =

getValueOrCreateConstantIndexOp(rewriter, loc, loopRange.offset);

Value sizeVal =

getValueOrCreateConstantIndexOp(rewriter, loc, loopRange.size);

Value strideVal =

getValueOrCreateConstantIndexOp(rewriter, loc, loopRange.stride);

auto loop = rewriter.create<scf::ForOp>(op.getLoc(), offsetVal, sizeVal,

strideVal, ValueRange{});

loops.push_back(loop);

ivs.push_back(loop.getInductionVar());

rewriter.setInsertionPoint(loop.getBody()->getTerminator());

}

if (failed(op.generateScalarImplementation(rewriter, op.getLoc(), ivs))) {

return failure();

}

return loops;

}

Diagnostic

1

mlir/include/mlir/IR/Diagnostics.h

Dominance

1

2

mlir/include/mlir/IR/Dominance.h

mlir/lib/IR/Dominance.cpp

DominanceInfo

class DominanceInfo : public detail::DominanceInfoBase</*IsPostDom=*/false>

返回一个 region-like 的 dominance

常见函数

下面的 T 可以是 Operation * 或 Value *

1.bool dominates(T *a, Operation *b): 判断a是否支配b

如果a是Operation,则返回

a == b || properlyDominates(a, b)如果a是Value,则返回

(Operation *)a.getDefiningOp() == b || properlyDominates(a, b)

2.Bool properlyDominates(T *a, Operation *b)

如果a是Operation,则直接调用 properlyDominatesImpl

- 如果a是Value(BlockArguement / OpResult)

- a是BlockArgument,则

dominates(blockArg.getOwner(), b->getBlock()); - 反之

properlyDominates((Operation *)a.getDefiningOp(), b)

- a是BlockArgument,则

- properlyDominatesImpl(Operation *a, Operation *b, bool enclosingOpOk)

- 当 a 和 b 位于不同区域且 a 包含 b,此时 a 并不会被视为支配 b(enclosingOpOk = false)

- 其实当 block 相同时,是检查 “在 block 中 a 的位置在 b 之前” (

a->isBeforeInBlock(b))是否成立

例如下面的例子中:

- properlyDominatesImpl(opA, opB, true) = true

- properlyDominatesImpl(opA, opB, false) = false

- properlyDominatesImpl(opA, opC, true) = true

- properlyDominatesImpl(opA, opC, false) = true

1

2

3

4

5

6

7

8

9

10

11

region0 {

^bb0 {

opA

(opA)region1 {

^bb1 {

opB

}

}

opC

}

}

这个 dominance 方法注意和 isProperAncestor 区别开,前者要求判断前后次序,后者是判断是否在子region中。

1

2

3

4

5

6

bool Operation::isProperAncestor(Operation *other) {

while ((other = other->getParentOp()))

if (this == other)

return true;

return false;

}

当寻找一个 op 是否在一个 region 内部时,可以使用 Operation *Region::findAncestorOpInRegion

3.bool hasSSADominance(Block *block) -> hasSSADominance(block->getParent())

4.bool hasSSADominance(Region *region)

判断region中的ops是否都满足SSA支配关系

如果region中不满足,则无法分析出dominanceInfo,遍历order需要修改

5.DominanceInfoNode *getRootNode(Region *region)

- 获得给定region的root dominance node,输入的region必须有多block

DominanceInfoNode

支配树节点 llvm::DomTreeNodeBase<Block>

有一个 SmallVector<DomTreeNodeBase *, 4> Children;

begin() / end() 都是以 Children 为对象。下面的代码是CSE pass遇见多block的region的遍历行为

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

// currentNode->node 就是 DominanceInfoNode,即 llvm::DomTreeNodeBase<Block>

while (!stack.empty()) {

auto ¤tNode = stack.back();

// 检查当前node是否被处理

if (!currentNode->processed) {

// 处理该节点

currentNode->processed = true;